Adobe: KI-generierte Bilder von Israel-Konflikt im Umlauf

Fake News und irreführende Inhalte sind gefährlich, ganz besonders, wenn sie im Zuge eines Krieges auftauchen. Das trifft natürlich auch auf den Konflikt zwischen Israel und der Hamas im Gaza-Streifen zu. Laut Business Insider sind derzeit KI-Bilder von Adobe im Umlauf, die den Israel-Konflikt darstellen. Während einige offensichtlich computergeneriert sind, sind andere realistischer, darunter ein Bild, das einige kleinere Websites und Social Media-User:innen geteilt haben. Das große Problem dabei: Die Bilder sind oft nicht gut ersichtlich als KI-generiert gekennzeichnet. Es entsteht die Sorge, dass dadurch schwere Fehlinformationen über den Konflikt in Umlauf geraten.

Wie Israels Startup-Sektor trotz des Krieges weiter funktioniert

KI-Bilder oft nicht klar gekennzeichnet

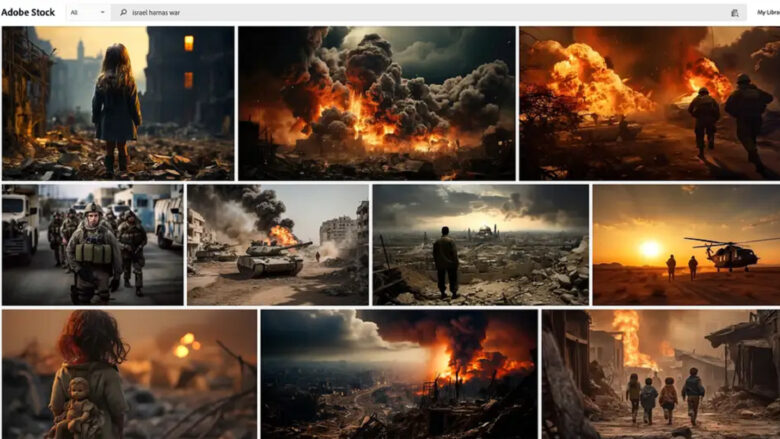

Eine Suche nach „Israel-Hamas-Krieg“ in Adobe Stock zeigt eine Reihe von Bildern, die vom Krieg zerrissene Straßen, Explosionen, Soldaten, Panzer, brennende Gebäude und in Trümmern stehende Kinder zeigen. Adobe Stock, das Bilder verkauft, die einzelne Künstler:innen eingereicht haben, verlangt, dass alle KI-generierten Bilder auf der Plattform eine entsprechende Kennzeichnung erhalten. Einige der zum Verkauf stehenden Bilder sind jedoch nur im Kleingedruckten als KI-generiert gekennzeichnet, nicht aber in ihrem Titel.

„Große Explosion, die die Skyline in Palästina erhellt“, lautet der Titel eines KI-generierten Bildes. „Durch den Krieg zerstörte Gebäude im Gazastreifen in Israel“, heißt es auf einem anderen. Ein Bild, das eine Frau in Not zeigt, trägt den Titel „Verwundete israelische Frau klammert sich an einen Militärmann und bittet um Hilfe.“ Einige der Bildtitel erwähnen KI. Ein KI-generiertes Bild mit dem Titel „conflict between israel and palestine generative ai“ sieht tatsächlichen Bildern aus dem Krieg ähnlich und machte online die Runde.

Grok: Elon Musk AI-Startup xAI schickt schimpfendes LLM ins Rennen gegen ChatGPT und Co

Adobe Stock bemüht sich um Transparenz

Eine Google-Suche nach dem Bild in umgekehrter Reihenfolge zeigt, dass es im Internet in Beiträgen, Videos und in sozialen Medien neben dem ursprünglichen Adobe-Link auftauchte. Die Suche führt auch zu anderen sehr ähnlichen, vermutlich echten Bildern aus dem Konflikt. Es ist unklar, ob diejenigen, die das KI-generierte Bild auf ihren Websites oder in ihren Beiträgen in sozialen Medien verwendet haben, sich bewusst waren, dass es sich nicht um ein echtes Foto handelt.

„Diese speziellen Bilder wurden als generative KI gekennzeichnet, als sie gemäß diesen Anforderungen eingereicht und zur Lizenzierung zur Verfügung gestellt wurden“, sagte ein Adobe-Sprecher in einer Erklärung gegenüber dem Business Insider. „Wir glauben, dass es für Kund:innen wichtig ist, zu wissen, welche Adobe Stock-Bilder mit generativen KI-Tools erstellt wurden. Adobe hat sich verpflichtet, Fehlinformationen zu bekämpfen. Über die Content Authenticity Initiative arbeiten wir mit Verlagen, Kameraherstellern und anderen Stakeholdern zusammen, um die Einführung von Content Credentials, auch in unseren eigenen Produkten, voranzutreiben“, so das Statement weiter.

Massiver Ausfall bei OpenAI und ChatGPT (Update: Es läuft wieder)

Fake News über Israel-Konflikt weit verbreitet

Fehlinformationen und Desinformationen über den Krieg zwischen Israel und Hamas sind im Internet bereits weit verbreitet. Irreführende Inhalte, alte Videos und Fotos aus anderen Konflikten in anderen Teilen der Welt und sogar Videospielmaterial haben sich als echte Fotos aus dem noch nicht beendeten Konflikt präsentiert. Und da KI-generierte Inhalte sowohl realistischer als auch weiter verbreitet sind, kann es schwierig sein, zu erkennen, ob ein Bild echt ist oder nicht, vor allem, wenn selbst KI-Bilddetektoren leicht zu täuschen sind.

Und wie bei KI-generierten Bildern ist es viel schwieriger, die Kennzeichnung eines KI-Bildes zu kontrollieren, nachdem es ein:e Nutzer:in heruntergeladen hat. Schließlich gibt es keine Garantie dafür, dass jemand die Herkunft des Bildes oder die Tatsache, dass es sich um ein KI-Bild handelt, eindeutig feststellt. Expert:innen sagen, dass solche Bilder oft übermäßig stilisiert aussehen und ästhetische Unstimmigkeiten bei der Beleuchtung, den Formen oder anderen Details aufweisen.