AI-Chatbots entwickeln sich schneller weiter als Computerchips

Der technologische Fortschritt von Large Language Models kann analysiert werden. Ein Forscherteam der Cornwell University in New York hat herausgefunden, dass sich die großen Sprachmodelle rasant weiterentwickeln und ihre Leistung noch schneller steigern können als Computerchips. Die Mengen an Energie, die für ihren Betrieb gebraucht werden, sind dabei allerdings nicht zu unterschätzen.

Mehr als 200 Sprachmodellevaluierungen

Die Forscher:innen haben herausgefunden, dass sich die Rechenleistung durchschnittlich alle acht Monate halbiert, um den gleichen Benchmark wie Computerchips zu erreichen. Dafür wurden mehr als 200 Sprachmodellevaluierungen aus den Jahren 2012 bis 2023 durchgeführt. Die Erkenntnis deutet auf eine Effizienzsteigerung im Vergleich zu vielen anderen Bereichen der Datenverarbeitung hin und überschreitet sogar das Mooresche Gesetz. Dieses besagt, dass sich die Anzahl der Transistoren auf einem Chip jedes regelmäßig verdoppeln. Je nach Quelle werden 12, 18 oder 24 Monate als Zeitraum genannt. Die Transistoren deuten auf die Rechenleistung eines Chips hin.

Performance-Steigerung durch bessere Algorithmen

Dass KI-Modellen eine so hohe Leistung erzielen, hat vor allem mit der Entwicklung der Algorithmen zu tun, auf denen sie basieren. Indem LLMs in ihrer Größe hochskaliert werden, kann die Performance noch weiter gesteigert werden, ist in der Studie zu lesen. Die Skalierung wird als wichtigster Haupttreiber für Leistungsverbesserungen genannt. Dafür braucht es allerdings auch mehr Rechenleistung, die wiederum von der Verfügbarkeit der KI-Chips abhängt. Aktuell sind diese Mangelware. Ergebnisse zur Weiterentwicklung von Algorithmen konnten nicht ermittelt werden, da der Code von vielen LLMs nicht öffentlich einsehbar ist. „Insgesamt liefert unsere Arbeit eine quantitative Einschätzung des raschen Fortschritts bei der Sprachmodellierung”, schreiben die Forscher:innen in ihrer Studie.

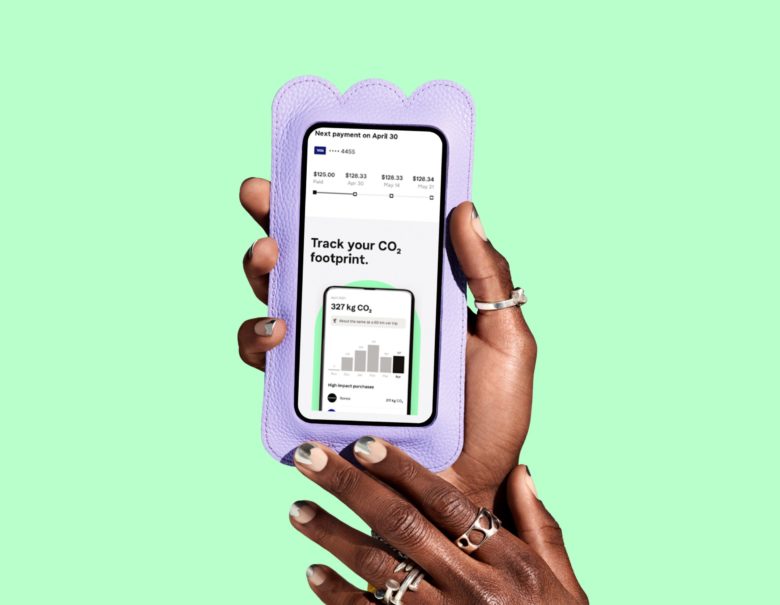

Effizientere KI-Modelle verbrauchen mehr Energie

Dr. Sasha Luccioni, Forscherin zu Klima und Künstlicher Intelligenz bei Hugging Face erwähnt in Bezug auf die Studie, dass effizientere KI-Modelle dazu führen können, dass sie mehr genutzt werden, berichtet t3n. Insgesamt kann also ein höherer Energieverbrauch durch KI entstehen, so Luccioni. In ihrem jüngsten TED-Talk merkte sie außerdem an: „Die Wolke, auf der die KI-Modelle leben, besteht in Wirklichkeit aus Metall und Plastik und wird mit riesigen Mengen an Energie betrieben. Und jedes Mal, wenn Sie ein KI-Modell abfragen, kostet es den Planeten.“