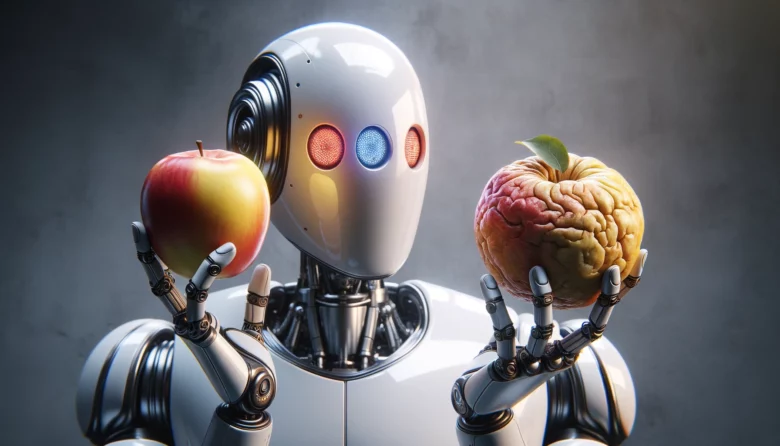

Wer mit Open Source arbeitet, bekommt meist die schlechteren AI-Modelle

Nicht OpenAI ist der große Gegner von Google, sondern Open Source: Das war zumindest die interne Meinung so mancher AI-Expert:innen bei Google mit Blick auf künftige Entwicklungen. Aktuell zeigt sich das aber gar nicht – denn vielmehr ist OpenAI im Gespann mit GPT-4 und Microsoft als Partner und Großinvestor jene AI-Firma, an der sich nicht nur Google, sondern die gesamte AI-Branche messen muss. Mit der Veröffentlichung von Sora im Videobereich später im Jahr wird sich das noch einmal verschärfen.

Währenddessen sieht man regelmäßige Veröffentlichungen von Open-Source-Modellen: Google hat Gemma veröffentlicht, Meta seine Llama-2-Modelle, und Elon Musks xAI hat nun am Wochenende Grok-1 unter Apache-Lizenz 2.0 auf den Markt gesetzt. Sprich: Im Prinzip kann jede:r hinüber zu Github oder Hugging Face surfen und sich diese AI-Modelle herunterladen. Das verheißt in der Theorie, dass sich jede:r (Firma) einen eigenen ChatGPT-Rivalen auf eigenen Servern mit eigenen Daten bauen könnte, um nicht in Abhängigkeit zu OpenAI, Microsoft und Co zu geraten.

Offen, mit Abstrichen

Jedoch zeigt sich aktuell Folgendes: Zwar werden immer wieder Open-Source-Modelle von Big Tech und aufstrebenden AI-Startups wie Mistral AI oder xAI veröffentlicht. Aber: Meistens (siehe Tabelle) sind die besseren, schnelleren und größeren AI-Modelle proprietär, bleiben also unter der Kontrolle eines Unternehmen. Diese AI-Modelle haben keinen öffentlich zugänglichen Quellcode und können nur unter Lizenz genutzt werden. Die Lizenz bekommt man im Alltag meistens via Kreditkarte zu spüren – die braucht es nämlich, um entweder die von den Unternehmen gebotenen Chatbots (ChatGPT, Le Chat, Copilot usw.) in der Vollversion verwenden zu können, oder um Zugang zu den AI-Modellen via API zu bekommen.

Außerdem gibt es dann auch bei den offenen KI-Modellen Einschränkungen. Beispiel xAI, das am Wochenende Grok-1 veröffentlichte. Zwar kann man sich den Code bereits bei GitHub oder Hugging Face besorgen, aber leider nicht in der Version, in der das Modell im Grok-Chatbot zum Einsatz bekommt. Stattdessen bekommt man eine Version aus einer Vor-Trainings-Phase ohne Finetuning, was auch bedeutet: Grok-1 hat noch nicht gelernt, Dialoge zu führen. Aus Benchmark-Tests und auch der Praxis weiß man außerdem, dass etwa die offenen Llama-2-Modelle von Meta nicht mehr mit den proprietären Modellen von OpenAI, Google oder auch Mistral AI mithalten können.

Weiters geht man etwa bei Google (Gemma) oder Meta (Llama) Nutzungsbedingungen ein, die zwar die kommerzielle Verwendung erlauben, aber nur unter Bedingungen. Hier ein Überblick:

| Open Source Models | Proprietary Models | |

| Gemma 2B* Gemma 7B* |

Gemini 1.5 Pro Gemini 1.0 Pro Gemini 1.0 Ultra Gemini 1.0 Nano |

|

| xAI | Grok-1 314B** | – |

| Meta | Llama 2 7B***

Llama 2 13B*** Llama 2 70B*** |

– |

| OpenAI | Whisper

GPT-2 |

GPT-4 Turbo GPT-4 GPT-3.5 Turbo |

| Mistral | Mistral 7B**

Mixtral 8x7B** |

Mistral Small Mistral Large Mistral Embed |

| Anthropic | – | Claude 3 Haiku Claude 3 Sonet Claude 3 Opus |

| Inflection AI | – | Inflection-2.5 Inflection-2 |

| Stability AI | SDXL Turbo Stable Diffusion XL Stable Code Stable LM |

Stable Diffusion 3 |

| Aleph Alpha | – | Luminous |

* Google-Lizenz, kommerzielle Nutzung erlaubt, aber unter Einschränkungen

** Apache License 2.0, kommerzielle Nutzung erlaubt

*** Facebook-Lizenz, kommerzielle Nutzung erlaubt, aber unter Einschränkungen

Insgesamt zeigt sich also: Open-Source-Modelle sind immer öfter verfügbar, aber wer die stärksten und aktuellsten AI-Modelle einsetzen möchte, der muss sie sich bei OpenAI, Google und Co via API lizensieren. Ab dann ist man nicht mehr User, sondern Kunde, und auch dem ausgeliefert, was die Anbieter entscheiden. Wenn etwa OpenAI durch ein Update GPT-4 spinnen lässt oder Google den Bildgenerator wegen Problemen abdreht, dann ist das eben so.

In der Praxis ist es schließlich auch oft so: Wer AI-Lösungen in seine Produkte integrieren will (z.B. AI-Chat im Kunden-Support), der tut sich leichter, via API auf AI-Modelle zuzugreifen, anstatt OS-Modelle zu laden, zu installieren, zu finetunen und zu betreiben. Es gibt auch Berichte und Berechnungen, dass die Nutzung via API günstiger ist, aus mehrerlei Gründen (u.a. Zeit- und Personalaufwand).

Open Source unter dem AI Act auch mit Regeln

In der EU gibt es auch zu bedenken, dass der Einsatz von Open-Source-KI keineswegs bedeutet, dass es dann auch keine Regeln einzuhalten gibt. Zwar gibt es im AI Act zwar Ausnahmen für Open Source, aber bestimmte Vorgaben gilt es beim Einsatz trotzdem zu erfüllen.

„Die neuen Regeln betreffen vor allem die großen KI-Modelle, wo die großen Sprachmodelle (LLMs) und die generative AI hineinfallen. Hier gibt es einen Zwei-Stufen-Approach. Stufe 1 gilt für Standard- oder normale General-Purpose-AI-Models. Hier gibt es Dokumentationspflichten, Pflichten zur Teilung von Informationen entlang der Lieferkette, eine Copyright-Policy und die Achtung von Rechtsvorbehalten und die Veröffentlichung einer Content Summary an Trainingsdaten. Dokumentation, Informationsveröffentlichung und Transparenz sind ja dem Open-Source-Gedanken inhärent. Stufe 2 sind die General-Purpose-AI-Models mit systemischen Risiken, die dann natürlich mehr Pflichten haben, wie Vorkehrungen gegen Cyber-Risiken“, sagt Jeannette Gorzala, die neue Stellvertreterin des KI-Beirats der Bundesregierung.

Und weiter: „Open Source ist grundsätzlich ausgenommen von all diesen Verpflichtungen, wenn es kein Modell mit systemischen Risiken ist. Das heißt, es gibt hier eigentlich eine großzügige Ausnahme. Das Einzige, wo Open Source-Modelle nicht ausgenommen sind, sind die Copyright-Policy und das Veröffentlichen der Trainings-Content-Summary, was ich auch hier nicht wirklich als einen Stolperstein sehe. Das heißt, der AI-Act ist für die Open Source-Industrie eigentlich gar nicht hinderlich, sondern hilft eigentlich auch, weil er genau definiert, was Open Source heißt.“

AI Advisory Board mit Jeannette Gorzala, Carina Zehetmaier und Verena Krawarik steht