Deepfakes: AI-Bilder lassen sich durch Analyse der Augäpfel entlarven

In einer Zeit, in der immer mehr Content mit KI-Bildgeneratoren kreiert wird, lässt sich kaum unterscheiden, ob es sich um ein echtes oder künstliches Foto handelt. “Mit Künstlicher Intelligenz (KI) erstellte Inhalte sind für den Menschen kaum bis gar nicht mehr zu erkennen”, wie wissenschaftlich nachgewiesen wurde. Doch die Studie der “Royal Astronomical Society” zeigt: Viele Deepfakes und KI-Bilder lassen sich anhand der Augen entlarven.

Immer wichtiger: Tools für Deepfake-Analyse

KI-generierte Fotos sind überall, sei es auf Dating-Plattformen, auf Social Media oder in den Medien. Umso wichtiger ist es, verlässliche Werkzeuge zu haben, mit deren Hilfe identifiziert werden kann, ob das Foto tatsächlich echt ist. Eine Studie, die auf der Nationalen Astronomietagung der Royal Astronomical Society in Hull vorgestellt wurde, legt nahe, dass KI-generierte Fälschungen durch die Analyse menschlicher Augen festgestellt werden können. Das Forscherteam verwendete für die Studie zwei öffentlich zugängliche Bilddatensätze. Insgesamt wurden 50 Fotos analysiert. “Was können sagen, ist, mit Gini können bis zu 70 Prozent der Fälschungen identifiziert werden“, so Kevin Pimblett, Professor für Astrophysik und Direktor des Exzellenzzentrums für Datenwissenschaft, künstliche Intelligenz und Modellierung an der Universität Hull zu Trending Topics. Der Teil „bis zu“ sei hier entscheidend.

Reflexion in den Augäpfeln

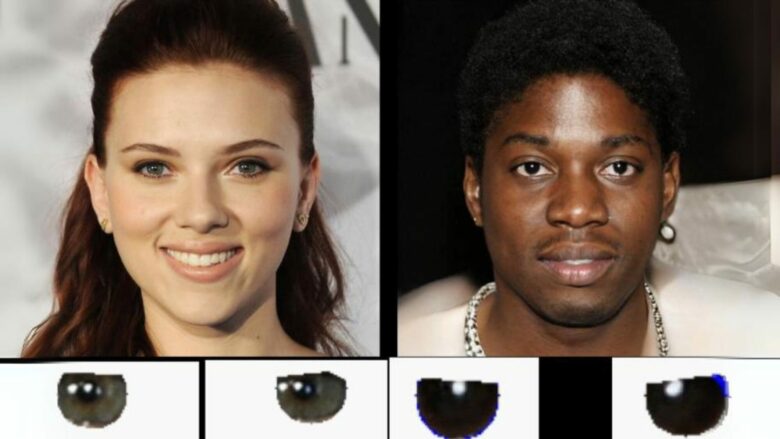

Ein Detail, mit dem sich KI bei der Vorstellung schwertut, ist die Reflexion in den Augäpfeln realitätsgetreu darzustellen. Das fanden Forscher:innen heraus, indem sie die Lichtreflexionen auf den Augäpfeln von Menschen in echten und von KI generierten Bildern analysierten. Herangezogen wurde dafür die Gini-Koeffizient-Methode. Diese Technik wird in der Astronomie eingesetzt, um zu bestimmen, wie das Licht in einem Galaxienbild auf die Pixel verteilt wird. Im Fall der Deepfakes wurde die Methode umfunktioniert und überprüfte anhand von morphologischen Merkmalen wie Konzentration, Asymmetrie und Glätte, ob die Reflexionen des linken und rechten Augapfels übereinstimmen. Wenn sich die Spiegelungen nicht decken, handelt es sich wahrscheinlich um ein Deepfake.

Wie das Beispielbild aus der Studie zeigt, reflektiert ein Auge fünf Lichtpunkte, während das andere nur drei zeigt. Das vierte Beispiel zeigt, dass die Lichtpunkte zwar grob übereinstimmen, aber kleinere Lichteffekte spiegelverkehrt auftreten. Handelt es sich um ein reales Foto, müssen sie identisch sein, da sie aus dem gleichen Winkel auf beide Augen fallen.

Einheitliche Reflexionen bei echten Bildern

„Die Reflexionen in den Augäpfeln sind bei der echten Person konsistent, bei der gefälschten Person jedoch (aus physikalischer Sicht) falsch“, so Pimbblet. Obwohl die Technik laut den Forscher noch nicht vollkommen zuverlässig für die Erkennung von Deepfakes ist, bietet sie eine Grundlage, um das Auffinden von Deepfakes in Zukunft zu verbessern.

AI-Copyright Regeln in Japan: Ausländische Tech-Unternehmen werden angezogen