Fake News? Diese AI erkennt, ob ein Text von einer AI oder einem Menschen geschrieben wurde

Harvard-Forscher und das MIT-Lab IBM Watson haben eine künstliche Intelligenz entwickelt, die anderen künstlichen Intelligenzen auf die Schliche kommt. AIs können nämlich Texte verfassen, die auch auf den zweiten Blick kaum von Texten unterschieden werden können, die Menschen geschrieben haben. Auf Social Media begegnet man solchen Kurz-Texten täglich – einige sind leicht zu identifizieren, andere wirken facettenreich genug, um echt zu klingen. AIs spielen aber auch eine Rolle bei der Erstellung und Verbreitung von Fake News. Die AI-Petze hat also durchaus seine Berechtigung.

+++ Ingrid Brodnig: „Menschen unterschätzen, wie anfällig sie für Fake News sind“ +++

Vorhersehbare Wortmuster

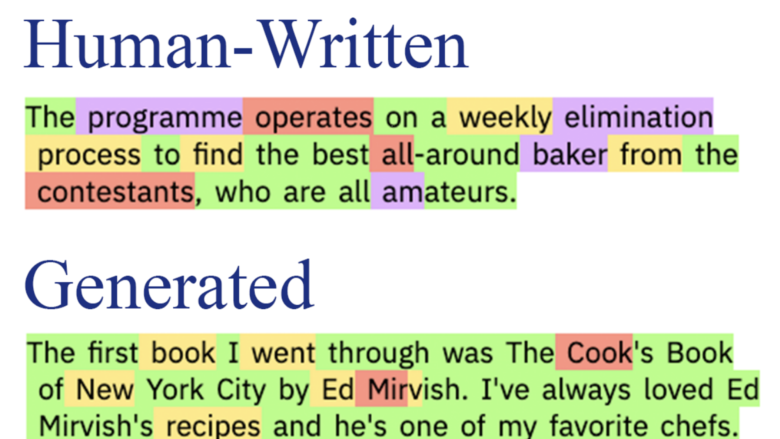

Die Wissenschaftler haben das Tool „Giant Language Model Test Room“ (GLTR) genannt und ihm beigebracht, zu erkennen, ob ein konkreter Text von einem Sprach-Modell-Algorithmus generiert wurde. Dem Konzept liegt die Annahme zugrunde, dass ein generierter Text besser vorhersehbare Wortmuster enthalten würde als ein von Menschen geschriebener Text. Häufig entstehen so zum Beispiel Sätze, die grammatikalisch korrekt sind, aber inhaltlich nichts zu der Geschichte des Textes beitragen.

So funktioniert die AI

GLTR schaut sich jeweils 30 Wörter an, die einem bestimmten Wort im Text vorangehen und folgen und sucht nach solchen Mustern. Das Tool ordnet die Wörter dann nach der statistischen Wahrscheinlichkeit, mit der sie auf dieses Wort folgen oder ihm vorangehen, in drei Kategorien. Ein normaler Text sollte aus einer guten Mischung aus Wörtern aller Kategorien bestehen, ein AI-Text enthält in der Regel keine oder kaum Wörter aus der Kategorie „am wenigsten wahrscheinlich“. Du kannst das Tool hier ausprobieren: GLTR – falls du dazu AI-generierte Texte brauchst, kannst du Talk to Transformer dafür verwenden.

>> Hier geht es zum Paper der Forscher