Explodierende Trainingskosten für AI-Modelle schießen Richtung 200 Mio. Dollar

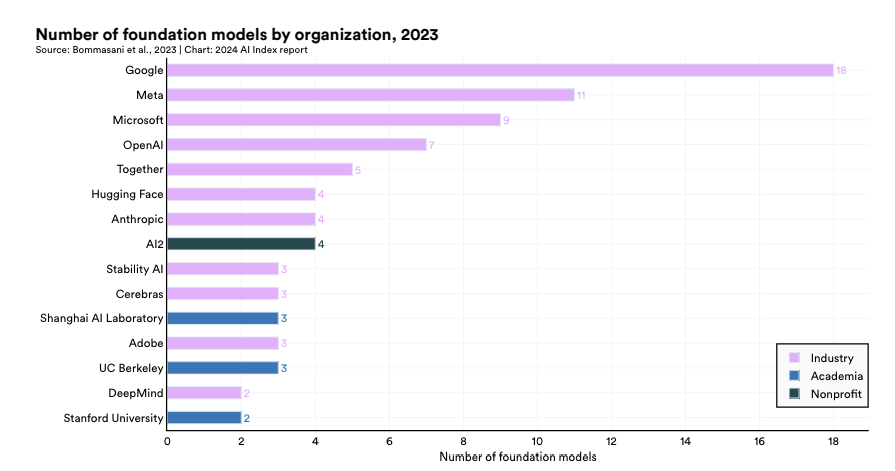

Die Zahl der veröffentlichten Foundation Models hat sich 2023 im Vergleich zum Vorjahr mehr als verdoppelt. Von den 149 neu vorgestellten Modellen waren 65,7 Prozent Open Source, ein deutlicher Anstieg gegenüber 44,4 Prozent im Jahr 2022 und 33,3 Prozent im Jahr 2021. Das geht aus dem aktuellen AI Index hervor, den die Universität Stanford veröffentlicht hat.

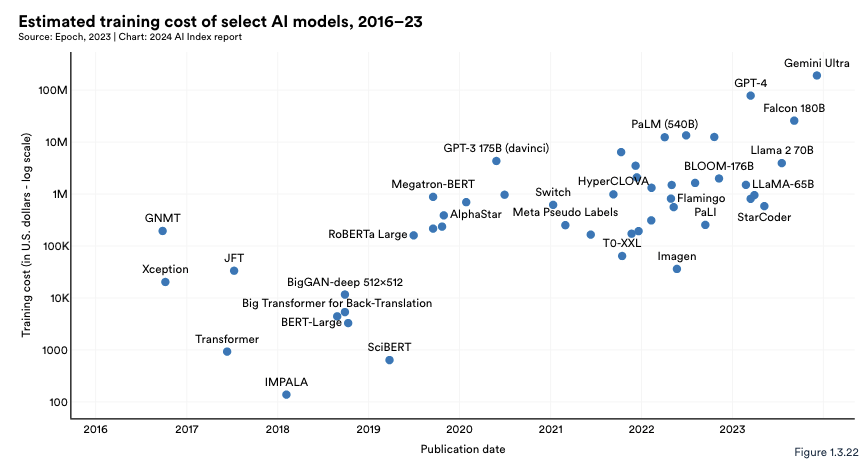

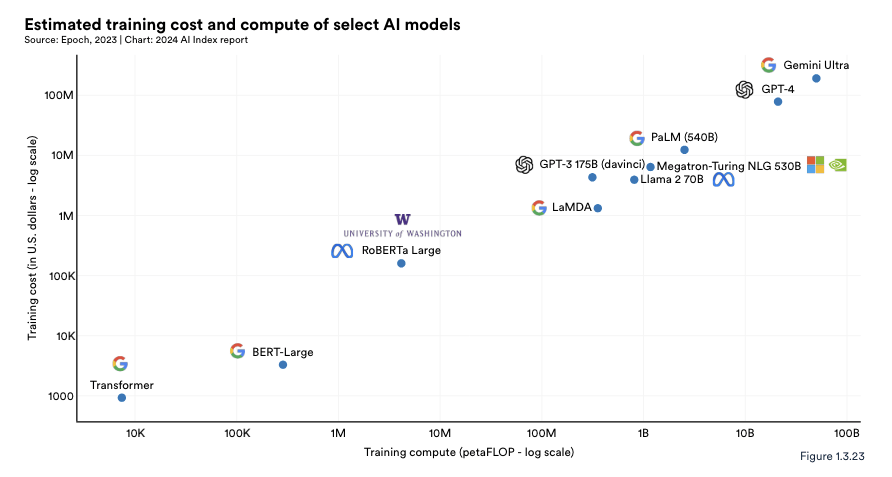

Laut Schätzungen des AI Index haben die Trainingskosten für modernste KI-Modelle ein beispielloses Niveau erreicht. So soll OpenAIs GPT-4 Rechenleistung im Wert von 78 Millionen Dollar für das Training benötigt haben, während Googles Gemini Ultra sogar 191 Millionen Dollar verschlungen haben soll.

Zum Vergleich: 2017 kostete das Training des ursprünglichen Transformer-Modells, das die Architektur einführte, auf der praktisch jedes moderne LLM basiert, rund 900 Dollar. RoBERTa Large aus dem Jahr 2019, das bei vielen kanonischen Verständnistests wie SQuAD und GLUE Spitzenergebnisse erzielte, kostete rund 160.000 Dollar im Training. Im Jahr 2023 werden die Trainingskosten für OpenAIs GPT-4 und Googles Gemini Ultra auf rund 78 Millionen bzw. 191 Millionen Dollar geschätzt.

Proprietäre Modelle schneiden deutlich besser ab als Open Source

Die USA sind weltweit führend bei der Entwicklung der besten KI-Modelle, noch vor China, der EU und Großbritannien. 2023 stammten 61 bemerkenswerte KI-Modelle von US-Institutionen, weit mehr als die 21 der Europäischen Union und die 15 aus China. Bei den KI-Patenten liegt China jedoch mit 61,1 Prozent im Jahr 2022 deutlich vor den USA mit 20,9 Prozent. Seit 2010 ist der US-Anteil an KI-Patenten von 54,1 Prozent gesunken.

Die Open-Source-KI-Forschung boomt. Seit 2011 ist die Zahl der KI-Projekte auf GitHub stetig gewachsen, von 845 im Jahr 2011 auf rund 1,8 Millionen im Jahr 2023. Allein 2023 gab es einen starken Anstieg der GitHub-KI-Projekte um 59,3 Prozent. Auch die Gesamtzahl der Sterne für KI-Projekte auf GitHub stieg 2023 deutlich an und verdreifachte sich von 4,0 Millionen im Jahr 2022 auf 12,2 Millionen.

Geschlossene LLMs schneiden deutlich besser ab als offene. Bei 10 ausgewählten KI-Benchmarks übertrafen geschlossene Modelle die offenen mit einem medianen Leistungsvorteil von 24,2 Prozent. Die Leistungsunterschiede zwischen geschlossenen und offenen Modellen haben wichtige Auswirkungen auf KI-Debatten.

Anzumerken ist, dass der Report unter anderem von Google und OpenAI, also den Anbietern von zwei der führenden AI-Modelle, gesponsert wurde.