Gemma 3: Google neueste AI-Modelle laufen lokal, schlagen DeepSeek und Llama

Der Trend in Richtung kleinerer, offener KI-Modelle geht nach dem DeepSeek-Einschlag weiter: Google hat Gemma 3 vorgestellt, eine neue Generation leichtgewichtiger KI-Modelle, die auf derselben Technologie basieren, die auch hinter den Gemini 2.0 Modellen steht. Gemma 3 wird als “das leistungsstärkste KI-Modell, das auf einem einzelnen Beschleuniger laufen kann” beworben und richtet sich an Entwickler, die KI-Anwendungen für verschiedene Plattformen erstellen möchten.

„Wir stellen Gemma 3 vor, eine Kollektion leichter, hochmoderner offener Modelle, die auf der gleichen Forschung und Technologie basieren wie unsere Gemini 2.0-Modelle. Dies sind unsere bisher fortschrittlichsten und verantwortungsvoll entwickelten offenen Modelle. Sie sind so konzipiert, dass sie schnell und direkt auf Geräten – von Handys und Laptops bis hin zu Workstations – ausgeführt werden können, damit Entwickler KI-Anwendungen erstellen können, wo immer sie gebraucht werden“, heißt es seitens Google Deepmind, also der AI-Tochter des Internet-Konzerns.

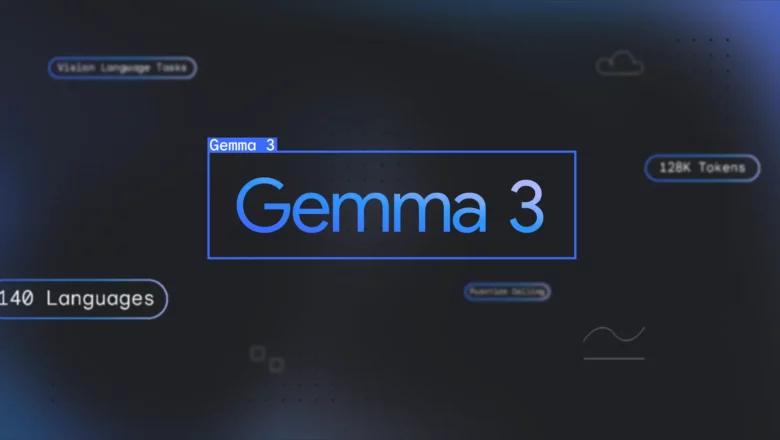

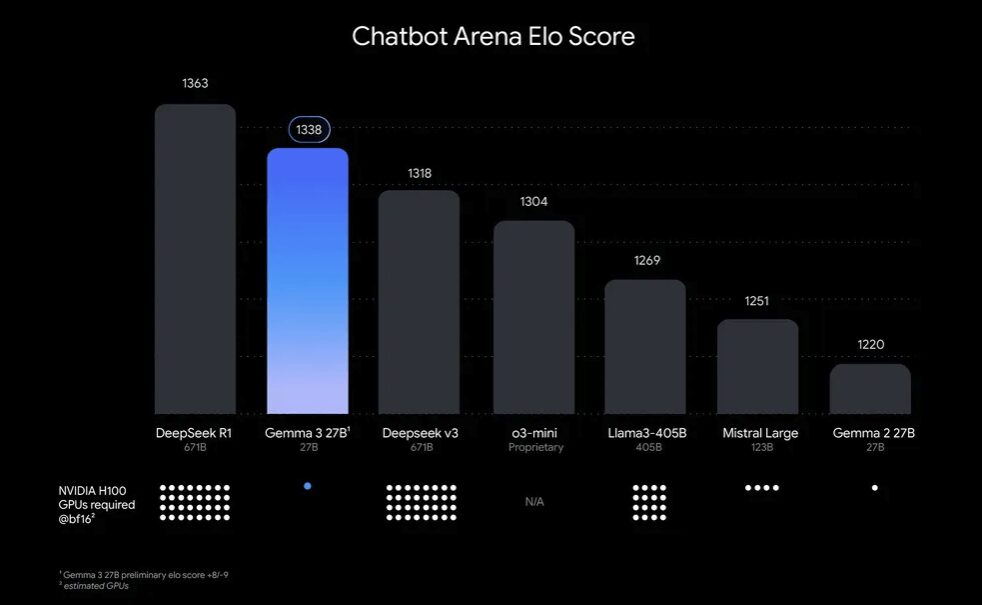

Gemma 3 ist in verschiedenen Größen verfügbar: 1B, 4B, 12B und 27B Parameter, wobei die größeren Modelle einen Kontext von 128.000 Token verarbeiten können, während das 1B-Modell auf 32.000 Token beschränkt ist. Die Modelle sind multimodal ausgelegt und können Text, Bilder und kurze Videos verarbeiten. Google zufolge soll Gemma 3 besser sein als Top-Modelle von DeepSeek, OpenAI, Meta oder Mistral, wenn es auch nicht an die Leistung von Googles proprietären Top-Modellen sowie einigen anderen Branchenführern herankommt:

Zu den Hauptmerkmalen gehören:

- Hohe Leistung auf einzelnem Beschleuniger: In vorläufigen Bewertungen übertrifft Gemma 3 Konkurrenten wie Llama-405B, DeepSeek-V3 und o3-mini auf der LMArena-Bestenliste.

- Multilinguale Unterstützung: Unterstützung für über 35 Sprachen direkt nutzbar und vortrainierte Unterstützung für mehr als 140 Sprachen.

- Erweitertes Kontextfenster: Mit 128.000 Token können große Datenmengen verarbeitet werden.

- Funktionsaufrufe: Unterstützung für strukturierte Ausgaben zur Automatisierung von Prozessen.

- Quantisierte Modelle: Offizielle quantisierte Versionen reduzieren die Modellgröße bei gleichbleibender Genauigkeit.

Kein echtes Open Source, aber vielfache Einsatzmöglichkeiten

Obwohl Google Gemma 3 als “open model” bezeichnet, ist es wichtig zu verstehen, was das genau bedeutet. Die Gemma-Lizenz ist eine von Google selbst erstellte Lizenz, die zwar viele Freiheiten bietet, aber nicht vollständig den Kriterien einer Open-Source-Lizenz im strengen Sinne entspricht.

Die Lizenz erlaubt eine breite Palette von Anwendungen, einschließlich kommerzieller Nutzung, Weiterverbreitung, Fine-Tuning und abgeleiteter Werke. Sie enthält jedoch Nutzungsbeschränkungen und auf die “Prohibited Use Policy” verweisen.

Vergleich mit anderen KI-Modellen

Im Vergleich zu anderen KI-Modellen wie Llama 3 zeigt Gemma 3 unterschiedliche Stärken und Schwächen:

- Leistung: Gemma 3 27B erreicht einen Elo-Score von 1338 auf der Chatbot Arena-Bestenliste und benötigt dabei nur einen einzigen NVIDIA H100 GPU, während Konkurrenten bis zu 32 GPUs für vergleichbare Leistung benötigen.

- Hardware-Anforderungen: Gemma 3 ist für den Einsatz auf Standard-GPUs oder einem einzelnen TPU optimiert, was es ideal für kleinere Setups macht. Im Gegensatz dazu benötigt Llama 3 leistungsfähigere Hardware, bietet aber bessere Skalierbarkeit und Anpassungsoptionen für größere Projekte.

- Anwendungsbereiche: Während Gemma 2 (der Vorgänger) in allgemeinem Wissen und Reasoning-Aufgaben stark ist, zeichnen sich die größeren Modelle von Gemma 3 (70B, 405B) in der Codegenerierung und beim Lösen mathematischer Probleme aus.

Gemma 3 integriert sich in bestehende Entwickler-Workflows mit Unterstützung für beliebte KI-Bibliotheken und Tools wie Hugging Face Transformers, JAX, PyTorch und Google AI Edge. Es ist optimiert für NVIDIA GPUs, unterstützt aber auch AMD GPUs über den ROCm-Stack und CPU-Ausführung mit Gemma.cpp. Für sofortige Experimente können Nutzer auf Gemma 3-Modelle über Plattformen wie Hugging Face und Kaggle zugreifen oder Google AI Studio für In-Browser-Deployment nutzen.