Google will bei Suche mit Lens Text und Bild kombinieren

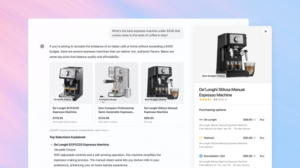

Google hat Pläne, um seine Suchfunktion in Zukunft noch deutlich stärker auszubauen und vor allem wesentlich visueller zu machen. Die Anwendung Google Lens soll es mit der neuen Funktion „Kombi-Suche“ ermöglichen, Bilder und Texte gleichzeitig für die Suche zu verwenden. Kombi-Suche ist derzeit weltweit auf Englisch verfügbar und der Konzern wird sie in den nächsten Monaten in über 70 weiteren Sprachen ausrollen, unter anderem auch in Deutsch. Das und mehr hat Google auf seinem Event Search On angekündigt.

„Kombi-Suche“ verbindet Text und Bild

„Wir stellen uns eine Welt vor, in der ihr genau das findet, was ihr sucht, indem ihr Bilder, Töne, Text und Sprache miteinander kombiniert, so wie es Menschen ganz natürlich tun. Wir nennen dies eine natürlichere und intuitivere Suche, und wir befinden uns auf einem langfristigen Weg, diese Vision für Menschen überall zum Leben zu erwecken“, heißt es vom Google-Team. Die Kombi-Suche soll die visuelle Suche komplett neu definieren und alle Arten von Informationen miteinander kombinieren.

Bei der Kombi-Suche müssen User:innen in der Google-App nur ein Bild machen und dann den Text zu ihrer Suchanfrage hinzufügen. Mit Kombi-Suche „In meiner Nähe“ wird diese Funktion um eine lokale Komponente ergänzt. Beispielsweise sollen Nutzer:innen ein Foto von ihrem Lieblingsessen machen und sich in der Google App lokale Restaurants anzeigen lassen, die genau dieses Gericht anbieten. Mit dieser Funktion sollen sich auch Produkte wie Kleidung, Pflanzen oder Haushaltswaren von lokalen Anbietern filtern lassen. „In meiner Nähe“ kommt ab Herbst 2022 in die USA.

Google Maps: Update für umweltfreundliche Navigation in Europa gestartet

Neues Update für Google Maps

Laut Google ist ein großer Vorteil der neuen Kombi-Suche die Fähigkeit, Sprachbarrieren zu überwinden. Dank der Fortschritte in der KI soll es möglich sein, nicht nur Texte, sondern auch Bilder zu übersetzen. Die Kombination aus Wörtern und Kontext soll den Suchen viel mehr Sinn verleihen. Dank der Machine Learning-Technologie „Generative Adversarial Networks“ (GANs) kann der Konzern jetzt in der Lage sein, übersetzten Text nahtlos in das Hintergrundbild einzufügen. Dieses verbesserte visuelle Erlebnis wird noch in diesem Jahr global eingeführt.

Ein weiteres Update gibt es bei Google Maps. Dank Fortschritten in der Computer-Vision und Vorhersagemodellen soll sich die Anwendung zu einer mehrdimensionalen Ansicht der realen Welt entwickeln. Nutzer:innen sollen Orte in Maps künftig live erleben können. Informationen wie das Wetter und die Auslastung eines Ortes sollen in die immersive Ansicht in Google Maps kommen.

Außerdem soll Maps bei Terminen einen Zoom in die Nachbarschaft und beispielsweise Restaurants erlauben, um ein Gefühl dafür zu bekommen, wie es an dem Tag und der geplanten Uhrzeit aussehen könnte – egal, ob der Termin morgen, nächste Woche oder in einem Monat stattfindet. Die erste Version dieser Funktion erweitert das Tech-Unternehmen nun mit Luftaufnahmen von 250 Sehenswürdigkeiten. In den kommenden Monaten wird die immersive Ansicht um ein Live-Feature erweitert, das auf fünf internationale Großstädte ausgedehnt wird (London, New York, Paris, San Francisco und Tokio), weitere sind in Planung.