Groq: AI-Chip-Startup sorgt mit Rekordwerten für Furore

Wer denkt, dass der Chip-Riese Nvidia aktuell das Non Plus Ultra in Sachen AI-Prozessoren ist, der irrt möglicherweise. Denn aktuell ist ein echtes Wettrennen um neue Chip-Unternehmen entstanden, die an dem hunderte Milliarden schweren Markt mitverdienen wollen. Mit Groq – nicht zu verwechseln mit dem LLM „Grok“ des Elon-Musk-Startups xAI – gibt es nun den ersten Jungstar einer blutjungen Branche.

Denn Groq begeistert Kenner:innen im Bereich der Künstlichen Intelligenz aktuell mit seinen so genannten Language Processing Units (LPUs), die speziell für das Verarbeiten von generativer AI auf Basis von Large Language Models (LLMs) entworfen wurden. Diese LPUs sollen sogar die GPUs (Graphic Processing Units) von Nvidia bei GenAI schlagen, die bisher die Branche dominieren und Nvidia wertvoller machten als Google oder Amazon (Trending Topics berichtete).

Technisch dreht sich bei Groq alles um die Optimierung der so genannten Inferenz, also der vereinfacht gesagt den Schlussfolgerungen, die ein AI-Modell auf Basis der Eingaben macht und daraus eine Antwort generiert. „Eine LPU ist ein neuartiges System von End-to-End-Verarbeitungseinheiten, das die schnellste Inferenz für rechenintensive Anwendungen mit einer sequenziellen Komponente, wie z. B. KI-Sprachanwendungen (LLMs), bietet“, heißt es dazu seitens Groq. Bedeutet: Wer schnelle, aber auch gute Antworten von einem AI-Modell will, der braucht eine gute Inferenz.

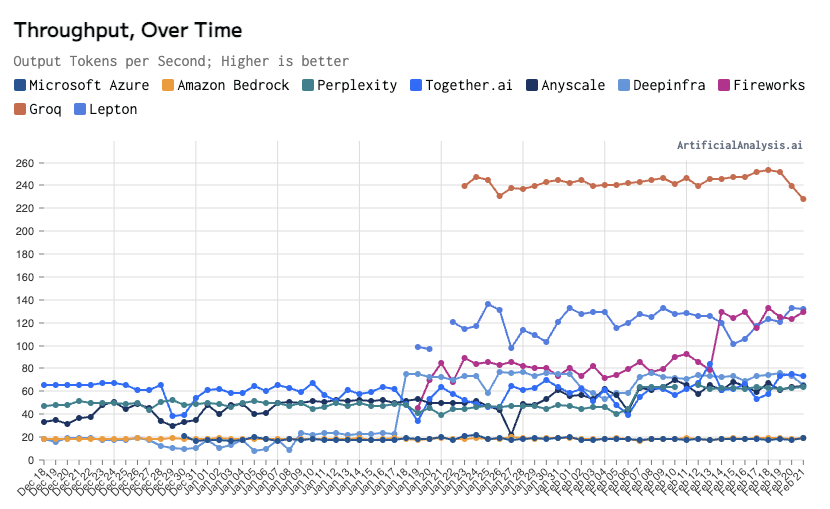

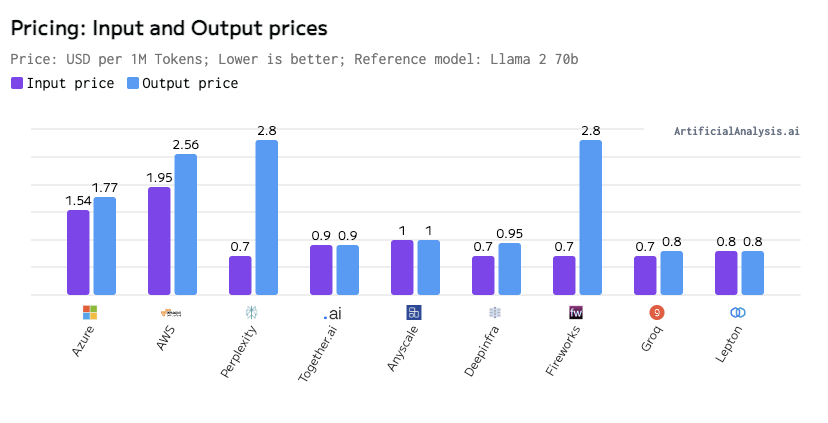

LPUs von Groq schlagen Clouds von Microsoft und Amazon um Längen

Neue Benchmark-Tests durch ArtificialAnalysis.ai, in die Groq mit seinen LPUs aufgenommen wurde, zeigen, dass diese neuartigen AI-Chips den Rechenzentren von Microsoft Azure, Amazon Webservices oder Anbietern wie Together.ai oder DeepInfra in manchen Punkten bereits deutlich überlegen sind. So schlägt Groq diese Branchengrößen etwa beim Durchsatz von Token pro Sekunde (Throughput) und beim Preis für die Berechnungen teilweise um Längen. Würde ChatGPT nicht auf Microsoft Azure laufen, sondern bei Groq, könnte es 13x schneller sein (247 Tokens/Sekunde vs. 18 Token/Sekunde):

Warum schaffen die LPUs das, was GPUs aktuell noch nicht können? „Die LPU wurde entwickelt, um die beiden Engpässe von LLMs zu überwinden: Rechendichte und Speicherbandbreite. Eine LPU hat eine größere Rechenkapazität als eine GPU oder eine CPU in Bezug auf LLMs. Dadurch wird die Zeit pro berechnetem Wort reduziert, so dass Textsequenzen viel schneller generiert werden können. Durch die Beseitigung externer Speicherengpässe kann die LPU Inference Engine außerdem eine um Größenordnungen bessere Leistung auf LLMs im Vergleich zu GPUs erzielen“, heißt es dazu seitens Groq.

Groq-Gründer rief Googles Tensor Processing Units (TPUs) ins Leben

Dass Groq plötzlich so gute Werte vorweisen kann, ist das Ergebnis langer Vorarbeit. Gegründet wurde das Startup mit Hauptsitz in Mountain View 2016 von Jonathan Ross, der zuvor bei Google das Projekt für die heute wichtigen Tensor Processing Units (TPUs) ins Leben rief. TPUs wurden speziell für TensorFlow entworfen und sind heute praktisch die technische Grundlage für alle Google-Services, die maschinelles Lernen einsetzen.

Ross hat seit der Gründung 2016 nicht nur eine ganze Reihe Talente an Standorten in den USA, Kanada und Großbritannien aufgebaut. Wer ausprobieren möchte, wie gut die LPUs funktionieren, kann das auf der Webseite von Groq tun. Dort werden die Open-Source-LLMs von Mistral (Mixtral 8X7B) und Meta (Lama 7B) eingebunden, um die Performance von Groq beispielhaft zu zeigen.

Bereits im April 2021, also lange bevor der große GenAI-Hype losging, hat Groq bereits eine große Finanzierungsrunde von 300 Millionen Dollar aufgenommen, unter anderem von Größen wie Tiger Global Management und D1 Capital. Seither hat das Unternehmen Samsungs Foundry-Sparte als Partner zur Chip-Produktion gewonnen und außerdem den Dataflow-Experten Maxeler Technologies aus London zugekauft. Vermutlich wird man bald weitere große News von Groq lesen.