Israelisches AI-Startup AI21: Jamba will Kontext besser verarbeiten können als andere

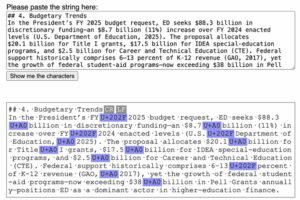

Das israelische KI-Startup „AI21 Labs” hat sich auf die Verarbeitung natürlicher Sprache spezialisiert. Laut dem „Vice President Product Management” Or Dagan müssen generative KI-Modelle nicht immer über große Kontextfenster verfügen und sollen die aufgenommen Daten trotzdem sehr gut erfassen können. Um das zu beweisen, hat AI21 sein eigenes generatives SSM-Transformer-Modell namens „Jamba“ herausgebracht.

Trend: Generative KI-Modelle mit längeren Kontexten

Kontexte oder Kontextfenster beziehen sich auf Eingabedaten, wie den Text, der in ein KI-Modell eingegeben wird, bevor es eine Ausgabe erzeugt. Der Großteil der KI-Branche konzentriert sich auf Modelle mit längeren Kontexten, die sehr rechenintensiv sind. Durch große Kontextfenster können in der Regel eingegebene Inhalte besser behalten werden, während Modelle mit kleineren Kontextfenstern dazu neigen, den geteilten Inhalt noch in derselben Unterhaltung schnell wieder zu vergessen. Vice President Product Management Dagan sagt dazu: „Es ist das erste Mal, dass wir bei AI21 Open-Source veröffentlichen. Jamba ist ein großartiges Basismodell, das im Begriff ist, eine hervorragende technologische Grundlage für echte Unternehmensanwendungen zu werden.”

GenAI-Innovation: AI21 Labs hat mit Jamba ein neues KI-Modell kreiert

Jamba ist ein neues Modell zur Texterzeugung und -analyse von AI21 Labs, das gestern der Öffentlichkeit vorgestellt wurde. Laut dem Startup kann es die gleichen Aufgaben lösen wie ChatGPT oder Gemini, will sich aber eben in Bezug auf die Größe der Kontextfenster unterscheiden. Was Jamba laut AI21 besonders macht, ist seine Fähigkeit, bis zu 140.000 Token auf einem einzigen Grafikprozessor mit mindestens 80 GB Speicher verarbeiten zu können. Kontextfenster werden in der Regel in Token gemessen, die sich aus Bits aus dem Rohtext und anderen Daten zusammensetzen. Jamba soll das einzige Modell seiner Größenklasse sein, das dies schafft. In natürlicher Sprache gemessen entspricht das etwa 105.000 Wörtern oder 210 Seiten, was einem Roman gleichkommt. Trainiert wurde Jamba aus einer Mischung von öffentlichen und firmeneigenen Daten. Es kann Texte in Englisch, Französisch, Spanisch und Portugiesisch schreiben.

Wie sich AI21 von anderen KI-Modellen unterscheiden will

Derzeit gibt es eine Vielzahl von frei verfügbaren generativen KI-Modellen, die sich frei herunterladen können. Die Konkurrenz wächst. Doch zieht man zum Beispiel das KI-Modell von Meta „Llama 2” heran, zeigt sich, dass hier ein eher kleines Kontextfenster mit 32.000 Token besteht. Dafür wird nur ein Grafikprozessor mit ungefähr 12 GB Speicher benötigt. Laut Benchmark-Tests soll das KI-Modell DBRX in Sachen Sprachverständnis, Programmierung, Mathematik und Logik besser sein als Llama, Mixtral-8x7B, Grok-1 oder sogar GPT-3.5 von Open AI – Trending Topics berichtete. Und es gibt noch viele weitere. Aber was Jamba einzigartig machen soll, ist die Kombination aus zwei Modellarchitekturen: Transformatoren und Zustandsraummodelle (SSMs). Erhältlich ist das neue KI-Modell bei Hugging Face und demnächst im NVIDIA API-Katalog.

Jamba ist noch nicht für den kommerziellen Einsatz bestimmt

Das neue KI-Modell wurde Open-Source unter der Apache 2.0-Lizenz mit relativ wenigen Nutzungsbeschränkungen veröffentlicht. Laut Dagan handle es sich noch um eine Forschungsversion, die nicht für den kommerziellen Einsatz gedacht ist. Das heißt, das Modell hat keine Sicherheitsvorkehrungen, die verhindern, dass es toxische Texte oder Verzerrungen erzeugt werden. Laut dem Entwickler soll eine fein abgestimmte, angeblich „sicherere“ Version in den kommenden Wochen auf den Markt kommen. Dennoch wird auf das Potenzial der SSM-Architektur hingewiesen, das Jamba schon jetzt aufzeigen soll. „Der Mehrwert dieses Modells besteht darin, dass es sowohl wegen seiner Größe als auch wegen seiner innovativen Architektur leicht auf einer einzigen GPU untergebracht werden kann“, so der Entwickler.

Canva holt immer mehr Startups in seinen Marktplatz. Aber was haben Startups davon?