KI-Wettrüsten: Sprachmodelle könnten CO2-Emissionen von Suchmaschinen vervielfachen

Das KI-Wettrüsten zwischen den Tech-Giganten ist bereits in vollem Gange. Während Microsoft mit ChatGPT zum Angriff auf Google bläst, versucht der Suchmaschinen-Konzern, mit seiner eigenen Anwendung Bard gegenzusteuern. Gleichzeitig arbeitet auch das chinesische Google-Pendant Baidu an einer ähnlichen KI. Bei all dem Hype um die beeindruckenden neuen Sprachmodelle kommt allerdings eine große Sorge auf: Nämlich die um den ökologischen Fußabdruck. Denn ChatGPT und Co erfordern eine enorme Rechenleistung und könnten den Energieverbrauch von Suchmaschinen wie Bing oder Google vervielfachen – und damit auch die CO2-Emissionen, berichtet Wired.

Magic.dev: „Wenn AI halbwegs fair verteilt wird, hat am Ende jede:r mehr“

Sprachmodelle erfordern riesige Datenmengen

„Die Indizierung und Durchsuchung von Internetinhalten verbrauchen bereits enorme Ressourcen, aber die Einbeziehung von KI erfordert eine andere Art von Feuerkraft“, sagt Alan Woodward, Professor für Cybersicherheit an der University of Surrey. „Sie braucht sowohl Rechenleistung als auch Speicherplatz und eine effiziente Suche. Jedes Mal, wenn sich die Online-Verarbeitung weiterentwickelt, steigt der Energie- und Kühlungsbedarf großer Rechenzentren deutlich an. Ich denke, dass dies ein solcher Schritt sein könnte“.

Das Training großer Sprachmodelle (LLMs), wie die, die OpenAIs ChatGPT zugrunde liegen, bedeutet das Berechnen von Verknüpfungen innerhalb riesiger Datenmengen. Deshalb sind für ihre Entwicklung oft beträchtliche Ressourcen nötig. Während weder OpenAI noch Google Angaben zu den Rechenkosten ihrer Produkte gemacht haben, schätzt eine internationale Analyse von Forscher:innen, dass das Training von GPT-3 etwa 1.287 MWh verbraucht und zu Emissionen von mehr als 550 Tonnen Kohlendioxid-Äquivalenten geführt hat – die gleiche Menge, die eine einzelne Person bei 550 Hin- und Rückflügen zwischen New York und San Francisco verursacht.

Künstliche Intelligenz hat deutlich höheren CO2-Abdruck als erwartet

Rechenleistung könnte sich verfünffachen

Das Training verursacht also relativ verschmerzbare Emissionen, jedoch ist es auch nötig, die Algorithmen für Millionen von Nutzer:innen verwendbar zu machen. Im vergangenen Jahr – kurz vor dem Ausbruch des KI-Hypes – hat Hugging Face eine Schätzung der Emissionen von LLMs durchgeführt. Dabei zeigte sich, dass die Emissionen deutlich höher werden, wenn man Faktoren wie die Herstellung der für das Training verwendeten Computerausrüstung, die breitere Computerinfrastruktur und die Energie, die für den Betrieb nach dem Training erforderlich ist, berücksichtigt.

Martin Bouchard, Mitbegründer des kanadischen Rechenzentrumsunternehmens QScale, ist der Ansicht, dass nach seinen Erkenntnissen über die Pläne von Microsoft und Google für die Suche die Integration von generativer KI in den Prozess „mindestens das Vier- oder Fünffache an Rechenleistung pro Suche“ erfordern wird.

Berliner Stromeffizienz-Startup Frequenz erhält 13 Mio. Euro

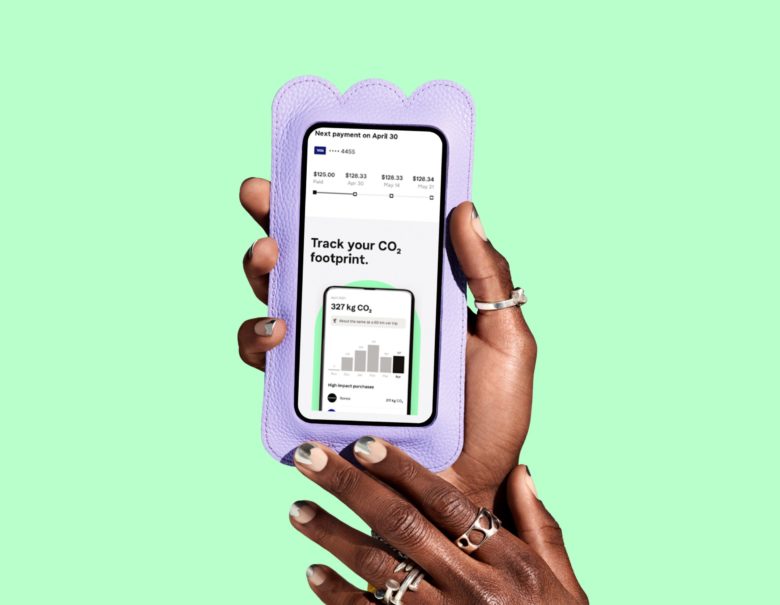

KI kann auch Stromeffizienz steigern

Nach Angaben der Internationalen Energieagentur sind Rechenzentren bereits für rund einen Prozent der weltweiten Treibhausgasemissionen verantwortlich. Es wird erwartet, dass dieser Anteil mit zunehmender Nachfrage nach Cloud Computing steigen wird. Damit sind Rechenzentren immer noch eine wesentlich geringere Klimabelastung als Transport und Verkehr, dennoch wäre ihr Beitrag zu den globalen CO2-Emissionen beträchtlich.

Microsoft hat sich allerdings verpflichtet, bis 2050 kohlenstoffneutral zu werden. Das Unternehmen beabsichtigt, in diesem Jahr Emissionszertifikate im Wert von 1,5 Millionen Tonnen zu kaufen. Google hat sich verpflichtet, bis 2030 im gesamten Unternehmen und in der gesamten Wertschöpfungskette Netto-Null-Emissionen zu erreichen. Rechenzentren könnten ihren Strom aus Erneuerbaren Energien beziehen. Außerdem können neuronale Netzwerke die Energieeffizienz deutlich erhöhen. Viele Startups, darunter Frequenz aus Berlin, setzen bereits auf KI, um den Einsatz von Strom zu optimieren.