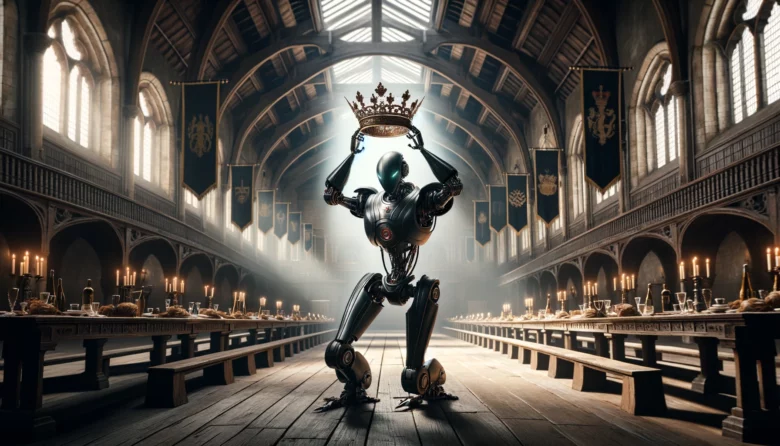

Who’s the King of LLM? GPT-4 vs. Claude 3 vs. Gemini 1.5 vs. Mistral Large

Es vergeht aktuell kaum ein Tag, an dem nicht irgendein neues Large Language Model (LLM) veröffentlicht wird. Mal sind es Organisationen und Unternehmen aus der Open-Source-Ecke, die neue Sprachmodelle auf den Markt werfen, mal sind es die Milliarden Dollar schweren Silicon-Valley-Startups, die ihre AI-Modelle nachrüsten. Dabei ist klar: Der König, der die Szenerie lange dominiert, ist mittlerweile geschlagen – denn eine Abspaltung von OpenAI hat es mit Google- und Amazon-Milliarden geschafft, GPT-4 vom Thron zu stoßen.

Nun ja, zumindest was die technische Seite angeht. Jedenfalls hat Anthropic, das von den ehemaligen OpenAi-Mitarbeiter:innen Daniela Amodei (Ex-OpenAI VP of Safety and Policy), Dario Amodei (Ex-OpenAI Vice President of Research), Jack Clark (Ex-OpenAI Policy Director) und Jared Kaplan (Ex-OpenAI Research Consultant) gegründet wurde, GPT-4 vom Thron gestossen. Claude 3 und insbesondere dessen stärkste Version „Opus“ schneidet in Tests besser ab als GPT-4 Turbo, das bislang beste AI-Modell von OpenAI. Das hat bisher sogar Google mit Gemini nicht geschafft. Der überraschende Platz 4, zumindest wenn es nach dem Ranking der bekannten Chatbot Arena geht, geht übrigens nicht an das gehypte französische Startup Mistral AI, sondern an Command R+. Dahinter steckt das AI-Startup Cohere mit Hauptsitz in Toronto, Kanada.

Hier eine Übersicht der wichtigsten aktuellen AI-Modelle, gerankt nach der Bestenliste der Chatbot Arena:

Je besser, desto teurer und geschlossener

Klar wird im Vergleich auch: Je besser ein AI-Modell ist desto weiter weg ist es von Open Source. Und nicht nur das: Wer damit via API arbeiten möchte, muss für die besten AI-Modelle oftmals das drei- bis fünffache bezahlen, als für schwächere, aber dafür günstigere Modelle verlangt wird. Die Geschäftsmodelle sind dabei eigentlich immer gleich: Für die Nutzung eines AI-Modells via API werden Gebühren für Input und Output berechnet, der Preis richtet sich dabei nach den verwendeten Token. Der Prozess der Umwandlung von Eingabetext in eine für das Modell lesbare Form passiert typischerweise in einer Sequenz von „Tokens“. Tokens können Wörter, Teilwörter oder sogar einzelne Buchstaben sein. Je mehr Input und Output, desto teurer also.

Schauten viele, die sich für AI-Modelle interessierten, 2023 noch stark auf die Zahl der Parameter, die AI-Modelle mitbringen, liegt mittlerweile mehr Augenmerk auf dem Kontextfenster – das geht so weit, dass viele Anbieter gar nicht mehr veröffentlichen, wie viele Milliarden Parameter ihre neuesten Schöpfungen haben, sondern kommunizieren lieber die Menge an Token des Kontextfensters. Hier hat mittlerweile bei den verfügbaren Modellen Google mit einer Million Token die Nase vorne, dahinter folgt Anthropics Claude (200.000), und erst danach kommen GPT-4 (128.000), Command R+ (128.000) oder Mistral Large (32.000). Für Durchschnittsnutzer:innen, die schnell mal kurze Fragen bei ChatGPT eingeben, ist das Kontextfenster irrelevant – im Business-Umfeld, in dem große Datensätze zur Bearbeitung eingegeben werden wollen, sind große Kontextfenster aber wichtig. Anthropics Claude mit 200.000 Token etwa soll ganze Börsenprospekte, die viele hunderte Seiten lang sein können, zusammenfassen können. Je größere Kontextfenster, umso mehr Business, könnte man sagen.

In Sachen Kontextfenster könnte auch ein in Österreich gestartetes Startup eine wichtige Rolle spielen. Denn Magic.dev von Eric Steinberger und Sebastian De Ro, mittlerweile ordentlich von Alphabets Investment-Arm Capital G und anderen Silicon-Valley-Größen finanziert, will ein LLM mit einem Kontextfenster von fünf Millionen Token kreiert haben – also 5x mehr als das bisher auf dem Gebiet führende Modell, Gemini 1.5 Pro von Google. Noch aber ist es anders als andere AI-Modelle nicht frei zugänglich (mehr dazu hier).

GPT-4 in der Nutzung weit vorne

So gut neue AI-Modelle von Anthropic, Cohere, Google oder Mistral AI auch sein mögen, in der Nutzung führt mit Abstand OpenAI mit GPT-4. Nicht nur, dass ChatGPT mehr als 100 Millionen User hat und die kostenpflichtige Business-Version von weltweit 600.000 Unternehmen lizensiert wurde, GPT-4 steckt natürlich auch in Microsofts Copilot drinnen, der quer durch das Produktportfolio des IT-Riesen integriert wurde. Gegen GPT-4 ist selbst Googles Gemini, das aktuell mit allen Mitteln in den Markt gedrückt wird vergleichsweise klein. Dem Analyse-Dienst SimilarWeb zufolge ist ChatGPT mittlerweile größer als die zweitgrößte Suchmaschine Bing und vier bis fünf Mal größer als Gemini. Microsofts Copilot, Anthropics Claude oder Perplexity (setzt auf GPT-4 Turbo und Claude 3) spielten zumindest zumZeitpunkt der SimilarWeb-Messung im Februar 2024 nur kleine Nebenrollen.

OpenAI und Meta werden bald nachlegen

Aktuell lässt sich festhalten: Anthropic (Claude 3), Google (Gemini), Cohere (Command R) und Mistral AI haben im vergangenen Jahr zum Branchenkönig GPT-4 aufholen können, zumindest technisch. Jedoch dürfte es sich nur um Wochen handeln, in denen es noch die Augenhöhe gibt. Denn bereits im Mai wird erwartet, dass Meta Llama 3 auf den Markt bringen wird. Das ist einerseits dringend notwendig, da Llama 2 längst weit abgeschlagen ist; zum anderen auch deswegen spannend, weil Meta durch den Content von Facebook und Instagram über schier unendliche Datenmengen verfügt, die man zum Training neuer AI-Modelle heranziehen könnte – kein anderes Unternehmen hat so viele Daten zu menschlicher Sprache in Wort und Bild wie Meta. Wie wichtig diese Daten sind, zeigt sich an zwei Beispielen: So soll OpenAI Millionen Stunden an YouTube-Videos transkribiert haben, um an Textmengen zu kommen; und Google zahlte Reddit kolportierte 60 Mio. Dollar pro Jahr, um deren Social-Plattform via API anzapfen zu dürfen.

Und dann ist da natürlich noch GPT-5. Es ist ein offenes Geheimnis, dass OpenAI am Nachfolger des Schlagers GPT-4 längst arbeitet. Gerüchte besagen, dass GPT-5 bereits im Sommer veröffentlicht werden könnte. Microsoft dürfte sich auf dieses Großereignis schon mal einstellen, indem es die Inflection-AI bzw. Deepmind-Founder zu sich holte, damit diese die neue Microsoft AI-Sparte leiten. Ihre Aufgabe wird es sein, die GPT-Kreationen nicht nur in den Copilot, sondern auch in die Suchmaschine Bing und den Browser Edge zu bringen. Es bleibt also vor allem eines: spannend.