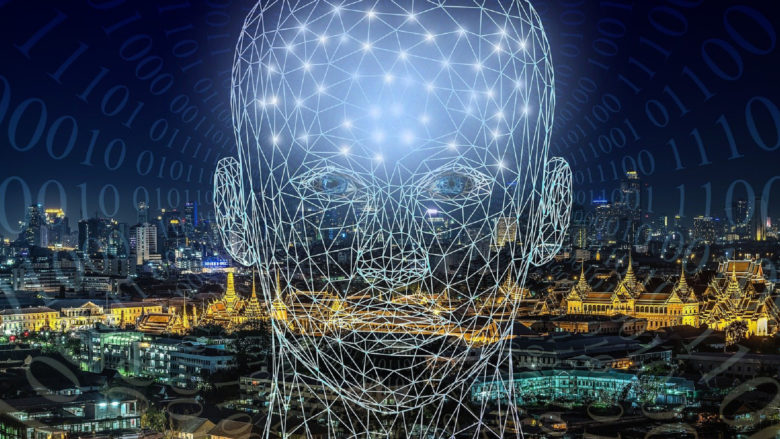

Künstliche Intelligenz hat deutlich höheren CO2-Abdruck als erwartet

Eine hohe Computer-Rechenleistung erfordert oft hohen Energieaufwand – womit wiederum in der Regel starke CO2-Emissionen verbunden sind. Das hat sich beispielsweise beim Mining von Kryptowährungen wie Bitcoin immer wieder gezeigt. Doch auch Künstliche Intelligenz kann einen hohen ökologischen Fußabdruck haben. Das US-Unternehmen Hugging Face hat es sich zum Ziel gemacht, deren Emissionen zu messen. Ein besonderer Fokus liegt dabei auf „Large Language Models“ (LLMs), also Sprachmodelle, die in der Lage sind, Texte zu verstehen und zu generieren. Dabei zeigt sich, dass die Klimabelastung durch solche Modelle, die mit gewaltigen Datenmengen trainiert werden, wesentlich höher ist als erwartet, berichtet MIT Technology Review.

Wie künstliche Intelligenz Lebensmittel vor dem Müll retten könnte

Neuer Ansatz für Berechnung der Emissionen

Hugging Face hat nach eigenen Angaben einen neuen Ansatz gefunden, um die CO2-Emissionen von LLMs genauer zu berechnen. Das Unternehmen schätzt die Emissionen, die während des gesamten Lebenszyklus des Modells und nicht nur während des Trainings entstehen. Um diesen neuen Ansatz zu testen, schätzte Hugging Face die Gesamtemissionen für sein eigenes LLM Bloom, das Anfang des Jahres auf den Markt kam.

„Unser Ziel war es, über die Kohlenstoffemissionen des während des Trainings verbrauchten Stroms hinauszugehen und einen größeren Teil des Lebenszyklus zu berücksichtigen, um der KI-Gemeinschaft zu helfen, eine bessere Vorstellung von ihren Auswirkungen auf die Umwelt zu bekommen und herauszufinden, wie wir diese reduzieren können“, sagt Sasha Luccioni, Forscherin bei Hugging Face und Hauptautorin der Studie.

Hohe Datenmengen für KI-Training

LLMs sind in der Regel mehrere Dutzend Gigabyte groß. Sie werden auf Basis von enormen Mengen von Textdaten trainiert, manchmal im Petabyte-Bereich. Sie gehören auch zu den größten Modellen in Bezug auf die Anzahl der Parameter, wobei sich ein „Parameter“ auf einen Wert bezieht, den das Modell während des Lernens unabhängig ändern kann. Parameter sind die Teile des Modells, die aus historischen Trainingsdaten gelernt wurden und die im Grunde die Fähigkeiten des Modells für ein Problem, wie beispielsweise die Generierung von Text, definieren.

Viele verschiedene Zahlen musste das Team von Hugging Face bei der Analyse in Betracht ziehen. Dazu gehören die Energiemenge, die für das Training des Modells auf einem Supercomputer nötig war, die Energie, die für die Herstellung der Hardware des Supercomputers und die Instandhaltung seiner Recheninfrastruktur gebraucht wurde, und die Energie, die für den Betrieb nach der Bereitstellung benötigt wurde.

GridX: Deutsches Startup optimiert das Laden von E-Autos durch künstliche Intelligenz

Energieverbrauch von vielen Langstreckenflügen

Das Ergebnis: Hugging Face schätzte, dass die Ausbildung von Bloom zu 25 Tonnen Kohlenstoffemissionen führte. Die Forscher:innen fanden jedoch heraus, dass sich diese Zahl verdoppelt, wenn sie die Emissionen berücksichtigen, die durch die Herstellung der für das Training verwendeten Computerausrüstung, die breitere Computerinfrastruktur und die Energie, die für den Betrieb nach dem Training erforderlich ist, entstehen.

Es scheint sich bei Bloom um ein sehr umweltbelastendes Modell zu handeln. 50 Tonnen CO2-Emissionen entsprechen etwa 60 Flügen zwischen London und New York. Dennoch gibt Hugging Face an, dass es nicht das umweltschädliche LLM dieser Größe ist. Das liege daran, dass Bloom auf einem französischen Supercomputer trainiert wurde, der größtenteils mit Kernenergie betrieben wird. Modelle, die in China, Australien oder einigen Teilen der USA trainiert wurden, seien stärker auf fossile Brennstoffe angewiesen. Das mache sie wahrscheinlich sogar noch umweltschädlicher.

Translated: Gründer kauft alte Wassermühle für grünere Künstliche Intelligenz

KI-Vorgänge summieren sich

Nach dem Start von Bloom schätzte Hugging Face, dass die Nutzung des Modells etwa 19 Kilogramm Kohlendioxid pro Tag ausstößt. Das entspricht in etwa den Emissionen, die bei einer Fahrt von etwa 54 Meilen mit einem durchschnittlichen Neuwagen entstehen. Dagegen sollen die Modelle GPT-3 von OpenAI und OPT von Meta während des Trainings schätzungsweise mehr als 500 bzw. 75 Tonnen Kohlendioxid ausstoßen. GPT-3 wurde auf älterer, weniger effizienter Hardware trainiert, was die Emissionen in die Höhe treiben soll. Zu bedenken ist hierbei, dass es sich um externe Schätzungen handelt, basierend auf begrenzt vorhandenen Daten.

Weil KI-Modelle heute in allen möglichen Bereichen zum Einsatz kommen, ist es laut der Studie wichtig, deren CO2-Emissionen in Betracht zu ziehen. So kommen beispielsweise Empfehlungs- und Werbealgorithmen häufig in der Werbung zu Einsatz. Viele Unternehmen wie Google oder Meta setzen auch KI-Modelle ein, um beispielsweise Nutzerkommentare zu klassifizieren oder Inhalte zu empfehlen. Diese Vorgänge verbrauchen laut den Forscher:innen zwar im Vergleich zu LLMs sehr wenig Strom, können aber eine Milliarde Mal pro Tag stattfinden. Das summiert sich.

Künstliche Intelligenz soll Entwicklungshilfe effizienter machen

Besseres Verständnis für Emissionen

Es wird geschätzt, dass der globale Technologiesektor für 1,8 Prozent bis 3,9 Prozent der weltweiten CO2-Emissionen verantwortlich ist. Obwohl nur ein Bruchteil davon durch KI und maschinelles Lernen verursacht wird, ist der CO2-Fußabdruck der KI für einen einzelnen Bereich innerhalb der Branche immer noch sehr hoch. Mit einem besseren Verständnis dafür, wie viel Energie KI-Systeme verbrauchen, können Unternehmen und Entwickler:innen entscheiden, welche Kompromisse sie zwischen Umweltverschmutzung und Kosten eingehen wollen, sagt Luccioni.