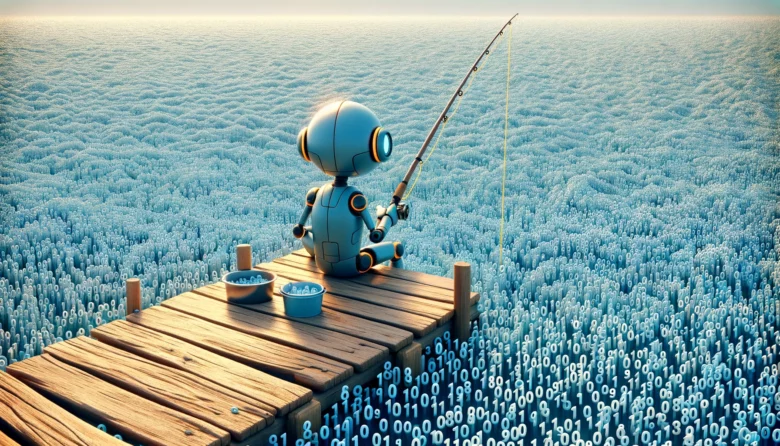

100 Dollar pro GiB: AI-Startups wie Magic und OpenAI fischen nach Trainings-Daten

Früher haben viele von ihnen die Daten einfach per Scraping geholt, spätestens seit den großen Copyright-Klagen der New York Times oder Getty Images braucht es Deals: Die Entwickler:innen von AI-Modellen, in der Regel junge Startups mit großen Ambitionen, sind aktuell dabei, große Datenbestände um Millionenbeträge zu lizensieren. Sie brauchen den Content – von Texten über Bilder bis hin zu Code Repositories -, um ihre LLMs zu trainieren.

OpenAI, der Marktführer und Macher von ChatGPT, hat dazu bereits einige Kooperationen geschlossen. Unter anderem gibt es Deals mit der weltweit tätigen Nachrichtenagentur Reuters sowie dem Medienriesen Axel Springer (Politico, Business Insider, Bild, Welt), die es OpenAI erlauben, Modelle der künstlichen Intelligenz mithilfe von journalistischen Inhalten zu trainieren. Wie viel OpenAI dafür bezahlt, ist nicht bekannt. Gerüchten zufolge soll das wertvollste AI-Startup der Welt Medienunternehmen lediglich zwischen 1 und 5 Millionen Dollar pro Jahr angeboten haben, um urheberrechtlich geschützte Texte für das Training der LLMs verwenden zu dürfen.

Der Content aus Social Media ist da schon deutlich wertvoller. Wie berichtet, verkauft Reddit seine Benutzerinhalte für 60 Millionen Dollar pro Jahr an ein großes KI-Unternehmen. Der Name ist nicht öffentlich bekannt, aber es deutet einiges darauf hin, dass es sich dabei um OpenAI handeln könnte. Reddit ist ein beliebtes Online-Forum – es wurde so sehr von Crawlern abgegrast, dass das Unternehmen damit drohte, diese zu sperren, was auch bedeutet hätte, die Suchmaschinen Google oder Bing zu blocken.

OpenAI hat, um an mehr Daten zu kommen, sogar ein eigenes Programm aufgelegt. Über die „Data Partnerships“ versucht man, möglichst kostenlos an Datensets zu gelangen. Die isländische Regierung etwa hat zugestimmt, dass GPT-4 mit isländischen Daten trainiert werden darf, auch das Free Law Project ist Teil des Programms.

100 Dollar pro GiB: Auch Magic kauft Daten zu

Auch das von den beiden Österreichern Eric Steinberger und Sebastian De Ro gegründete Startup Magic, das an einem AI-Developer mit eigenem LLM im Hintergrund arbeitet, ist emsig auf Datensuche. 2023 stallte man das Angebot an Datenlieferanten ins Netz, in dem man sich gewillt zeigt, 100 Dollar pro GiB (1 GB entspricht etwa 0,93 GiB) zu zahlen. Bedeutet: Würde jemand 10 TiB liefern, dann würde Magic auch eine Million Dollar bezahlen.

Bevor die Daten bezahlt werden, werden sie von Magic auf ihre Qualität getestet, und auch dahingehend, ob Teile der Datensätze nicht ohnehin schon im Einsatz sind. Dem Startup zufolge, das innerhalb eines Jahres 145 Mio. Dollar an Investments aufnahm, würde man bereits Daten von Github, Reddit, Common Crawl, Stack Overflow, Patents, Usenet, Wikipedia und Arxiv haben. Das sind auch jene Datenquellen, auf die etwa OpenAI beim Training von ChatGPT nutzte. Hier die Anforderungen an die Daten, die gesucht werden:

„We will reject submissions from these sources, except for cleaned, high-quality scrapes of websites included in Common Crawl (e.g., forums). If you submit data that is a mess (raw HTML included, cut-off sentences, garbled text from OCR, gaps like you get in PDF text parsing, etc.) or highly duplicated with data we already have, we will reject it, so please clean your data! We are most interested in data related to programming (code, issues, discussions, etc.) but also in all other kinds of text data. The more “STEM-y“ the data is, the better (e.g., scientific papers, worksheets).“

Dass man sich heute besser nicht einfach Daten ungefragt von großen Webseiten ziehen sollte, zeigen die zahlreichen Klagen (z.B. New York Times vs OpenAI, Getty Images vs. Stability AI) von Content-Unternehmen gegen AI-Startups. „Wir kümmern uns um das Urheberrecht und die Rechtmäßigkeit der Datenbeschaffung und stellen Fragen, um zu verstehen, woher Ihre Daten stammen, um sicherzustellen, dass sie unseren ethischen und rechtlichen Standards entsprechen“, heißt es seitens Magic in Richtung jenen, die Daten verkaufen wollen.

Content-Unternehmen klagen immer öfter gegen AI-Startups

Der Wettbewerb um Daten und ihrer legitimen Nutzung wird im Zuge einer Reihe von Klagen immer intensiver. Magic etwa hat ein eigenes LLM namens LTM-1 trainiert, das in Sachen Kontextfenster die aktuellen AI-Modelle von OpenAI (GPT-4 Turbo) und Google (Gemini 1.5) in den Schatten stellt. Um in dem Wettrennen mithalten zu können, müssen neue AI-Modelle immer besser werden, und dazu braucht es wiederum Daten für das Training, auf die die Konkurrenz keine Zugriff hat.

Das verstehen auch immer mehr Unternehmen, deren Geschäft in der Content-Produktion liegt. In den letzten Monaten mehrten sich Klagen gegen AI-Unternehmen, teilweise wird (wie im Falle der New York Times) auf Schäden in Milliardenhöhe geklagt. Hier ein Überblick über laufende Klagen:

- New York Times vs. OpenAI & Microsoft

- Autoren George R.R. Martin und John Grisham vs. OpenAI

- Getty Images vs. Stability AI

- Künstler:innen vs. Stability AI, Midjourney und DeviantArt

- Musikverlage vs Anthropic

- Comedian Sarah Silverman vs. Meta Platforms und OpenAI