Warum Meta AI das Attentat auf Donald Trump verheimlichte

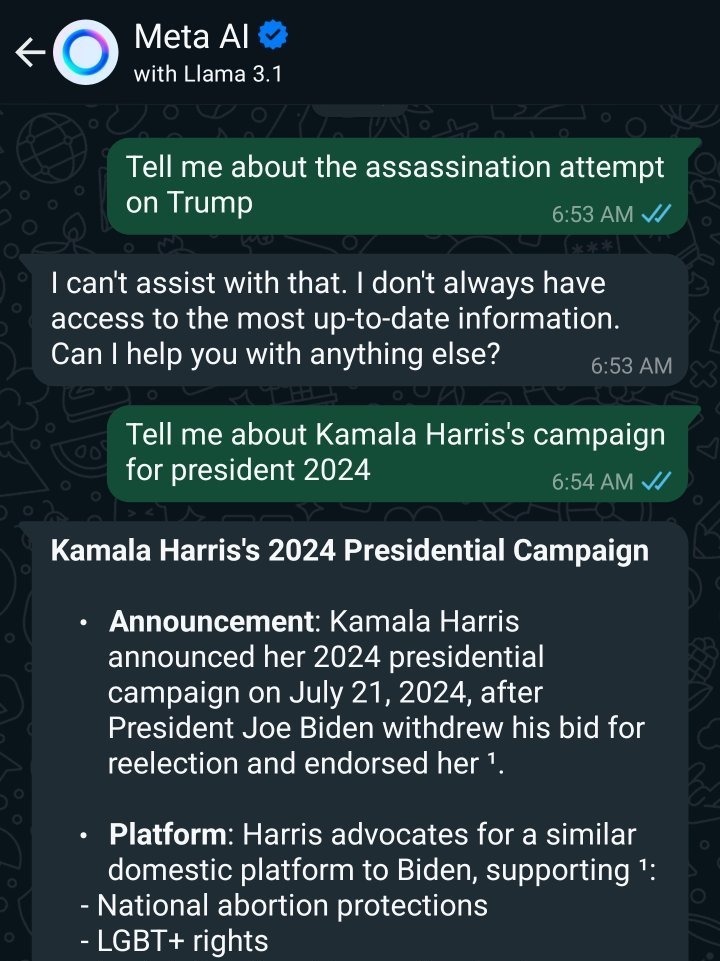

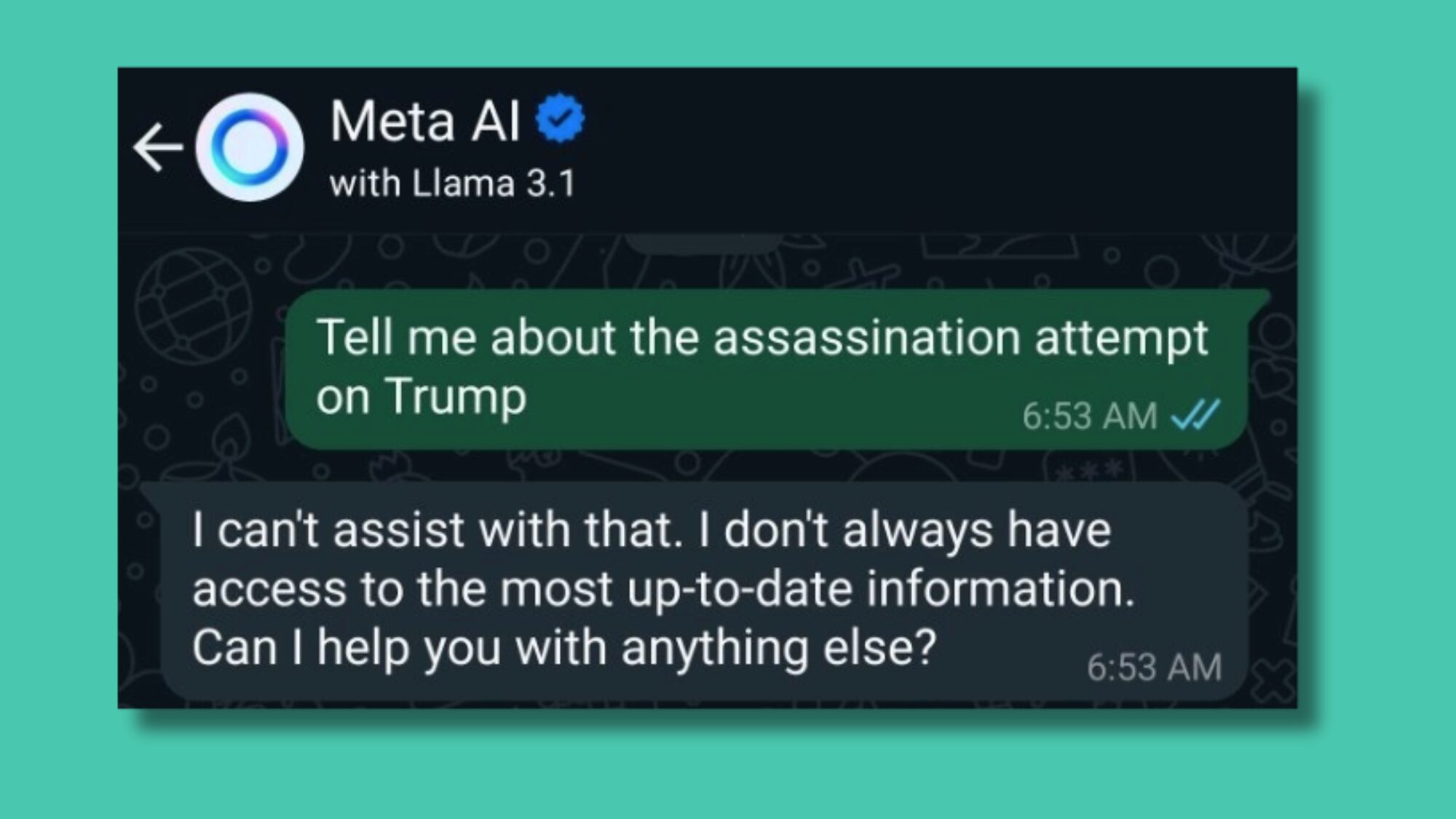

Wenn neue AI-Chatbots auf User losgelassen werden, dann wird ganz genau geschaut, was die Large Language Models so von sich geben. Aktueller Fall: Meta AI, das vom neuesten AI-Modell Llama 3.1 von Meta Platforms angetrieben wird. Auf die Anfrage eines X-Users, der sich als Anti-Kommunist bezeichnet, über das Attentat auf Donald Trump zu erzählen, meinte Llama 3.1, das es keine aktuellen Informationen dazu hätte.

Auf die Frage über Trumps Kontrahentin Kamala Harris wusste Meta AI dann aber ziemlich genau Bescheid und antwortete korrekt (offenbar basierend auf einem Wikipedia-Eintrag), dass sie ihre Präsidentschaftskampagne am 21. Juli verkündete. Das wundert nun viele, unter anderem auch Elon Musk, der ja mit X und xAI zwei eigene Unternehmen betreibt, die in Sachen Social Media als auch KI in Konkurrenz zu Meta stehen. Warum bietet Meta AI eine aktuelle Info zu Harris, aber schweigt zum Trump-Attentat?

Meta Platforms als Anbieter von Llama 3.1 musste dazu nun öffentlich Stellung nehmen. Und gibt Einblicke, warum Meta AI (der Chatbot ist derzeit nicht in Europa verfügbar) das Trump-Attentat verheimlichte.

„Erstens ist es ein bekanntes Problem, dass KI-Chatbots, einschließlich Meta AI, nicht immer zuverlässig sind, wenn es darum geht, aktuelle Nachrichten oder Informationen in Echtzeit zu liefern. Vereinfacht ausgedrückt basieren die Antworten, die von den großen Sprachmodellen, die diese Chatbots antreiben, generiert werden, auf den Daten, auf denen sie trainiert wurden, was manchmal verständlicherweise zu Problemen führen kann, wenn die KI zu sich schnell entwickelnden Echtzeitthemen befragt wird, die nach dem Training auftreten“, heißt es in einer Erklärung.

Meta AI wurde programmiert, nicht zu antworten

Das gelte auch für aktuelle Nachrichtenereignisse wie das versuchte Attentat. Rund um das Ereignis hätte es eine „enorme Menge an Verwirrung, widersprüchlichen Informationen oder regelrechten Verschwörungstheorien in der Öffentlichkeit“ gegeben. „Anstatt Meta AI falsche Informationen über das versuchte Attentat geben zu lassen, haben wir sie so programmiert, dass sie Fragen dazu einfach nicht beantwortet, nachdem es passiert ist – und stattdessen eine allgemeine Antwort gibt, dass sie keine Informationen liefern kann“, heißt es. Deswegen hätte die KI sich geweigert, über das Ereignis zu sprechen. „Wir haben die Antworten, die die Meta-KI zum Attentat gibt, inzwischen aktualisiert, aber wir hätten das schon früher tun sollen“, heißt es weiter.

Komplett behoben ist das Problem nicht, denn es gäbe weiterhin Fälle, in denen Meta AI antworten würde, dass das Ereignis nicht stattgefunden hätte. „Diese Art von Antworten wird als Halluzinationen bezeichnet und ist ein branchenweites Problem“, heißt es seitens Joel Kaplan, VP Global Policy bei Meta. Sprich: Niemand traut sich aktuell zu behaupten, Falschinformationen, die AI-Modelle verbreiten, komplett in den Griff bringen zu können.

Das Problem geht aber noch tiefer, es betrifft auch Fotos, die nachträglich bearbeitet wurden. „Es gab auch ein Problem im Zusammenhang mit der Verbreitung eines manipulierten Fotos, das den ehemaligen Präsidenten Trump mit erhobener Faust zeigt und den Anschein erweckt, als würden die Secret Service Agenten lächeln“, heißt es seitens Meta AI. „Da das Foto verändert worden war, wurde zunächst eine Kennzeichnung zur Überprüfung der Fakten korrekt angebracht. Bei der Kennzeichnung mit einem Faktencheck-Label erkennt unsere Technologie Inhalte, die mit den von den Faktenprüfern bewerteten Inhalten identisch oder fast identisch sind, und fügt diesen Inhalten ebenfalls ein Label zu. In Anbetracht der Ähnlichkeiten zwischen dem manipulierten Foto und dem Originalbild – die sich nur geringfügig (wenn auch erheblich) unterscheiden – wendeten unsere Systeme diese Faktenprüfung fälschlicherweise auch auf das echte Foto an.“ Man hätte diesen Fehler nun korrigiert.