Wer hat mehr H100? Die neue Währung der AI-Welt

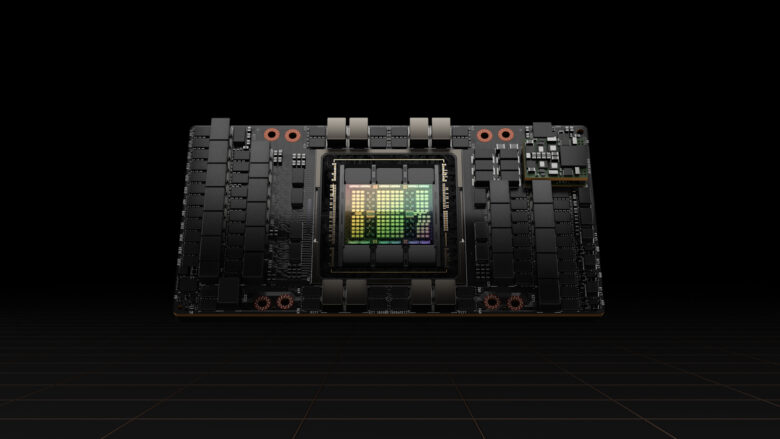

Als der US-Chipkonzern Nvidia im März 2022 seine neue Hopper-Architektur präsentierte und heraus posaunte, dass man damit einen „neuen Motor für die KI-Infrastruktur der Welt“ zur Verfügung stellte, da war das eher etwas für die Fachwelt. Auch das damals Alibaba Cloud, Amazon Web Services, Baidu AI Cloud, Google Cloud, Microsoft Azure, Oracle Cloud und Tencent Cloud ankündigten, große Mengen des damals neuen H100-Chips zu kaufen, war keine Sensation, und auch nicht die Randnotiz in der Pressemeldung, dass damit Chatbots auf Basis von Transformer Language Models möglich werden.

Dann kam im November 2022 der Launch von ChatGPT durch OpenAI, und was folgte, war das größte Wettrüsten bei Grafikprozessoren (GPUs), das die Welt je gesehen hat. Der Kaufrausch nach den H100-Chips von Nvidia war so groß, dass der Hersteller kurzzeitig zum wertvollsten Unternehmen der Welt aufstieg. Von März 2022 bis heute hat der Aktienkurs von Nvidia um 420 Prozent zugelegt, denn klar ist eines: Ohne die AI-Chips H100 gibt es kein ChatGPT, kein Claude von Anthropic, keine AI-Startups wie Mistral AI, Magic oder xAI von Elon Musk.

Der Motor der KI-Fabriken

„Hopper ist der neue Motor der KI-Fabriken, der Berge von Daten verarbeitet und verfeinert, um Modelle mit Billionen von Parametern zu trainieren, die für Fortschritte in der sprachbasierten KI, der Robotik, dem Gesundheitswesen und den Biowissenschaften eingesetzt werden“, sagte Jensen Huang, Gründer und CEO von Nvidia, damals bei der Präsentation. Mittlerweile ist die Anzahl der H100, die einem Unternehmen zur Verfügung stehen, derart wichtig, dass die Zahlen dazu aktiv kommuniziert werden wie sonst nur Investmentsummen, Umsatzzahlen oder Gewinne – unter anderem auch, um Fachkräfte anzuwerben und die Konkurrenz einzuschüchtern.

Neuester Fall: Elon Musks AI-Startup xAI. Dieses hat verkündet, in nur etwa 120 Tagen einen AI-Cluster namens Colossus mit stattlichen 100.000 der begehrten AI-Chips aufgebaut zu haben. Bei einem Preis von etwa 30.000 bis 40.000 Dollar muss man davon ausgehen, dass xAI für diese Menge mehrere Milliarden Dollar ausgegeben hat. Bis Ende des Jahres will man sogar auf 200.000 H100 verdoppeln. Damit ist auch klar, warum xAI dieses Jahr 6 Milliarden Dollar aufgenommen hat – um die Rechnung beim Chip-Lieferanten Nvidia begleichen zu können.

Egal ob 100.000 oder 200.000 H100 – öffentlich bekannt ist, das nur Meta Platforms von Mark Zuckerberg dieses Jahr mehr H100 von Nvidia kaufen wird, nämlich 350.000 Stück. Dafür müsste Meta wohl etwa zehn Milliarden Dollar ausgeben. Hier zum Vergleich einige andere bekannte Käufer von H100:

- Meta Platforms: 350.000 H100 (bis Ende 2024)

- xAI Colossus: 100.000 H100 (September 2024, 200.000 bis Ende 2024)

- Tesla: 85.000 H100 (bis Ende 2024)

- Inflection AI & Microsoft: 22.000 H100 (Mitte 2023)

- Andreessen Horowitz: 20.000 H100 (2024)

- Magic: 8.000 H100 (September 2024)

Zum Vergleich: In Österreich wird mit vergleichsweise kleinen Mengen an den AI-Chips gearbeitet. Bekannt ist etwa, dass das Institute of Science and Technology Austria (ISTA) kürzlich in einen hochmodernen Rechencluster von mehr als 100 H100 investiert hat.

B200: Nachfolger kommt, die Konkurrenz auch

Bei den H100 wird es nicht bleiben. Denn mit der Blackwell-Architektur hat Nvidia bereits den Nachfolger der begehren H100 vorgestellt, sie hören auf das Kürzel B200. Diese übertreffen mit 10 Petaflops den heutigen Goldstandard H100 (4 Petaflops) um das 2,5-Fache bei der Rechenleistung, mit 208 Milliarden hat der B200 fast drei Mal so viele Transistoren wie der H100 (80 Milliarden Transistoren). Kein Wunder, dass bei der Präsentation Google, Amazon, Dell Technologies, Google DeepMind, Meta, Microsoft, OpenAI, Oracle Tesla und xAI allesamt Kaufinteresse bekundeten.

Währenddessen wird auch daran gearbeitet, die Dominanz von Nvidia im AI-Chip-Bereich zu brechen. Google hat sich Qualcomm und Intel zusammengeschlossen, um Nvidia in dem Bereich Konkurrenz zu machen, Microsoft hat einen eigenen KI-Chip namens „Azure Maia“ angekündigt (mehr dazu hier), AMD hat Silo AI aus Finnland zugekauft, um sich zu stärken, und daneben arbeiten mehrere Startups wie etwa Groq an AI-Prozessoren, die H100 und B200 Konkurrenz machen sollen.

Nvidias neuer Blackwell-Chip soll die nächste Phase generativer AI einläuten