NXAI bringt kleines AI-Modell, will mit Energieeffizienz und Schnelligkeit punkten

Es ist nicht einfach nur ein weiteres LLM, sondern im Kern eigentlich der Angriff auf die bei AI-Modellen vorherrschende Trasnformer-Architektur. Jedenfalls: Das Linzer AI-Startup NXAI rund um KI-Forscher Sepp Hochreiter hat am Mittwoch Abend auf der NeurIPS-Konferenz in Vancouver das bereits vorangekündigte AI-Modell „xLSTM 7B“ vorgestellt.

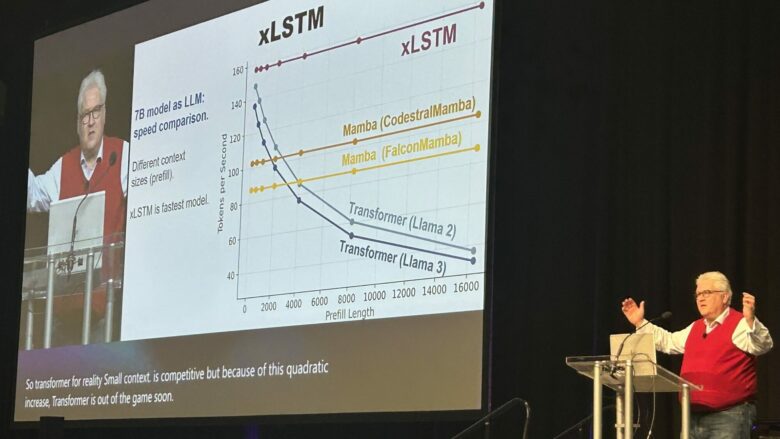

Es gehöre zur „Spitzenklasse der 7B-Modelle“ heißt es aus dem Unternehmen. Mit 7 Milliarden Parametern ist es vergleichsweise klein, in Benchmarks wird es deswegen vor allem mit Llama 3.1 8B von Meta, Gemma 2 9B von Google oder Mamba 2 verglichen und nicht etwa mit den Top-Modellen von OpenAi, Anthropic und Co. „Es hat sich zum besten Nicht-Transformer-Sprachmodell entwickelt, wie seine präzise Vorhersage des nächsten Wortes und die Ergebnisse bei Standard-Benchmarks wie Massive Multitask Language Understanding (MMLU) belegen“, heißt es in einer Aussendung.

„Das energieeffizienteste Modell in der Welt der LLMs“

„Es ist das energieeffizienteste Modell in der Welt der Large Language Models mit einer schnellen Inferenz“, so Hochreiter in einer Aussendung. Er lehrt an der JKU Linz und ist Chief Scientist bei NXAI. Einsatzgebiete wären vor allem im Edge- und Embedded-Bereich – also dort, wo AI-Modelle direkt auf Gerät oder Maschine installiert werden, wenig Rechenleistung und Energie brauchen und ohne die Cloud mit ihren Rechenzentren auskommen.

xLSTM wurde wie berichtet breits im Mai 2024 erstmals gezeigt, seither hätte man vor allem im Industriebereich Anwendung gefunden. Nun kann die xLSTM-Architektur via GitHub bezogen werden, ein vortrainiertes Modell steht auf Huggingface zum Finetuning bereit. Jeder Forscher weltweit kann das xLSTM 7B Modell für seine Arbeit nutzen. Es ist ein Modell aus Europa für die Welt“, so Hochreiter.

Das österreichische Startup will mit der „Long Short Term Memory“-Architektur gegen die dominierenden Transformer-Modelle, die ursprünglich aus der Google-Forschung stammen und durch OpenAI, Anthropic, Google, Meta, xAI, Amazon usw. weit verbreitet werden, einen europäischen Kontrapunkt setzen. Im Gegensatz zur Transformer-Technologie würden die xLSTM-Berechnungen nur linear mit der Textlänge und im laufenden Betrieb weniger Rechenleistung benötigen, heißt es dazu.