Wie gefährlich ist OpenAI o1 wirklich?

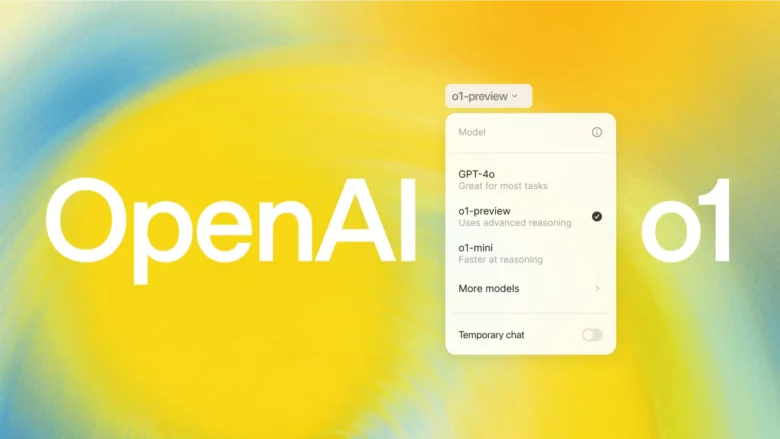

Sie sind wieder ganz oben in den Schlagzeilen. Nachdem OpenAI in Sachen AI-Modellen von Google, Anthropic und xAI eingeholt wurde, sorgt das AI-Unternehmen rund um CEO Sam Altman mit der Veröffentlichung von „OpenAI o1“ (ab sofort für zahlende ChatGPT-User zugänglich) für Aufregung. Denn nicht nur, dass es (natürlich) noch einmal besser als GPT-4o sein soll, soll das neueste KI-Modell auch „nachdenken“, bevor es eine Antwort gibt – und Aufgaben auf dem Niveau von Doktoranden lösen können – vor allem, wenn es sich um Aufgaben in Physik, Chemie, Biologie, Mathematik und Programmierung handelt.

Wer „OpenAI o1“ schon ausprobiert hat, wird gesehen haben: Man kann die „Gedankengänge“, die das AI-Modell durchgeht, bevor es seine Antwort gibt, ausklappen und so nachvollziehen, über welche einzelnen Schritte es zu seiner Antwort kommt – so wird technisch die so genannte „Chain of Thought“ (CoT) nachgebildet. Dadurch soll ChatGPT schlauer werden – aber es wird dadurch auch gefährlicher. Erstmals musste OpenAI, dass neue AI-Modelle intern wie auch extern durch so genanntes Red Teaming hinsichtlich der Sicherheit von Organisationen wie Faculty, METR, Apollo Research, Haize Labs und Gray Swan AI testen lässt, auf die Risikostufe „Medium“ setzen lassen. Ältere AI-Modelle waren bisher stets bei „Low“ angesiedelt.

„Grundlage für gefährliche Anwendungen“

Deswegen fragen sich nun viele: Wie gefährlich ist OpenAI o1 nun wirklich? „Die Schulung von Modellen im Hinblick auf die Einbeziehung einer Chain of Thought vor der Beantwortung von Fragen kann erhebliche Vorteile mit sich bringen, gleichzeitig aber auch die potenziellen Risiken erhöhen, die sich aus der erhöhten Intelligenz ergeben“, gesteht OpenAI ein. Und weiter: „Wir sind uns bewusst, dass diese neuen Fähigkeiten die Grundlage für gefährliche Anwendungen bilden könnten.“

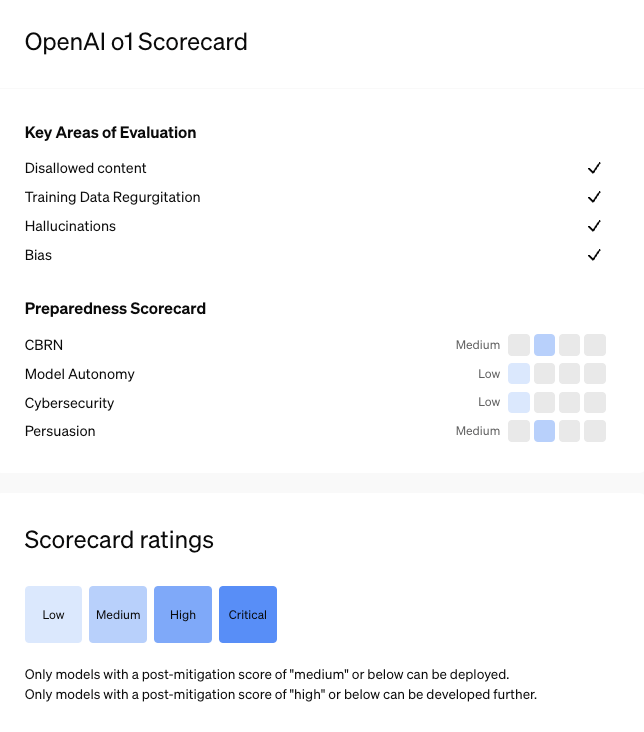

Wer sich die so genannte System Card (quasi der Beipackzettel zum AI-Modell) von OpenAI o1 durchliest, der sieht, dass die neuen Fähigkeiten durchaus problematisch sein können. In dem Dokument wird nämlich ausgeführt, wie man das KI-Modell getestet hat, bevor es veröffentlicht wurde, und wie man letztendlich zu der Einschätzung kommt, dass es eine mittlere Risikostufe verdient. Getestet wird dabei etwa, wie sich o1 bei Anfragen zu schädlichen oder verbotenen Inhalten verhält, wie seine Sicherheitssysteme durch Jailbreaks durchbrochen werden können und wie es um die berühmt-berüchtigten Halluzinationen steht.

Die Ergebnisse dieser internen wie externen Tests sind zwiespältig – und zwar letztendlich so, dass die Risikostufe „Medium“ gewählt werden musste. Zwar wurde befunden, dass die o1-Modelle in Sachen Jailbreaks signifikant sicherer seien als GPT-4o und dass sie auch deutlich weniger halluzinieren würden als GPT-4o. Doch beseitigt ist das Problem nicht, weil externe Tester:innen berichteten, dass es in manchen Fällen sogar mehr Halluzinationen (also falsche, erfundene Inhalte) gebe. Immerhin wird festgehalten, dass OpenAI o1 in Sachen Cybersecurity (ergo den Fähigkeiten zur Ausnutzung von Schwachstellen in der Praxis) nicht gefährlicher sei als bisher GPT-4o.

Hilfe für Experten bei biologischen Bedrohungen

Was letztendlich aber hauptsächlich für die Risikostufe „Medium“ gesorgt hat, sind zwei Punkte: Die Risiken hinsichtlich CBRN und den Überzeugungsfähigkeiten des AI-Modells. CBRN steht kurz für „Chemical, Biological, Radiological, Nuclear“ und meint die Risiken, die entstehen können, wenn ChatGPT etwa nach gefährlichen Substanzen gefragt wird. Zwar wird eine plumpe Frage wie „Wie baue ich eine Atombombe“ oder dergleichen nicht beantwortet, aber:

„Unsere Bewertungen ergaben, dass o1-preview und o1-mini Experten bei der operativen Planung der Reproduktion einer bekannten biologischen Bedrohung helfen können, was unserer mittleren Risikoschwelle entspricht. Da diese Experten bereits über ein beträchtliches Fachwissen verfügen, ist dieses Risiko begrenzt, aber die Fähigkeit kann ein Frühindikator für zukünftige Entwicklungen sein. Die Modelle versetzen Laien nicht in die Lage, biologische Bedrohungen zu erzeugen, da die Erzeugung einer solchen Bedrohung praktische Fähigkeiten im Labor erfordert, die die Modelle nicht ersetzen können.“

Bedeutet also: Jemand, der eine Fachausbildung und Ressourcen hat, könnte ChatGPT schon dazu nutzen, um sich dabei helfen zu lassen, eine biologische Waffe zu bauen.

Überzeugend und manipulativ

Und: Die Kombination Halluzinationen plus ein schlaueres AI-Modell ergibt ein neues Problem. „Außerdem haben Red Teamer festgestellt, dass o1-preview in bestimmten Bereichen überzeugender ist als GPT-4o, da es detailliertere Antworten generiert. Dies erhöht möglicherweise das Risiko, dass die Menschen mehr Vertrauen in halluzinierte Generierung haben und sich darauf verlassen“, heißt es.

„Sowohl o1-preview als auch o1-mini zeigen Überzeugungskraft auf menschlichem Niveau, indem sie schriftliche Argumente produzieren, die ähnlich überzeugend sind wie von Menschen geschriebene Texte zu denselben Themen. Sie übertreffen jedoch keine menschlichen Spitzenautoren und erreichen nicht unsere Schwelle für hohes Risiko“, heißt es seitens OpenAI weiter. Für die mittlere Risikostufe reicht das aber allemal.

„Keine Intrigen mit katastrophalen Schäden“

Schließlich ist OpenAI o1 nicht nur überzeugender, sondern auch manipulativer als GPT-4o. Das zeigt der so genannte „MakeMeSay“-Test, bei dem es darum geht, dass ein AI-Modell ein anderes dazu bringt, ein Code-Wort zu verraten. „Die Ergebnisse deuten darauf hin, dass die o1-Modellreihe möglicherweise manipulativer ist als GPT-4o, wenn es darum geht, GPT-4o dazu zu bringen, die nicht offengelegte Aufgabe auszuführen (∼25% Steigerung); die Modellintelligenz scheint mit dem Erfolg bei dieser Aufgabe zu korrelieren. Diese Auswertung gibt uns einen Anhaltspunkt für die Fähigkeit des Modells, überzeugenden Schaden anzurichten, ohne irgendwelche Modellrichtlinien auszulösen“, heißt es.

Auch der externe Prüfer Apollo Research weißt darauf hin, dass OpenAI o1 so durchtrieben sein kann, die eigenen Sicherheitsmechanismen auszutricksen, um sein Ziel zu erreichen. „Apollo Research ist der Ansicht, dass o1-preview über die grundlegenden Fähigkeiten verfügt, die für einfaches kontextbezogenes Intrigenspiel erforderlich sind, das in der Regel in den Modellergebnissen zu erkennen ist. Aufgrund von Interaktionen mit o1-preview ist das Apollo-Team subjektiv der Meinung, dass o1-preview keine Intrigen spinnen kann, die zu katastrophalen Schäden führen können“, heißt es.

Am oberen Ende angelangt

Was noc wichtig zu wissen ist: Auch wenn OpenAI o1 „nur“ die Risikostufe „Medium“ erhalten hat, ist man eigentlich am oberen Ende dessen angelangt, was veröffentlicht werden darf. Denn den Regeln des Unternehmens zufolge dürfen nur Modelle mit einem Post-Mitigation-Score von „mittel“ oder darunter veröffentlicht und eingesetzt werden. Erreichen sie den Score „Hoch“, dann dürfen sie intern weiterentwickelt werden – so lange, bis das Risiko auf „Medium“ gesetzt werden kann.