OpenAI o1: Bisher gefährlichstes AI-Modell soll auf PhD-Level denken (Update)

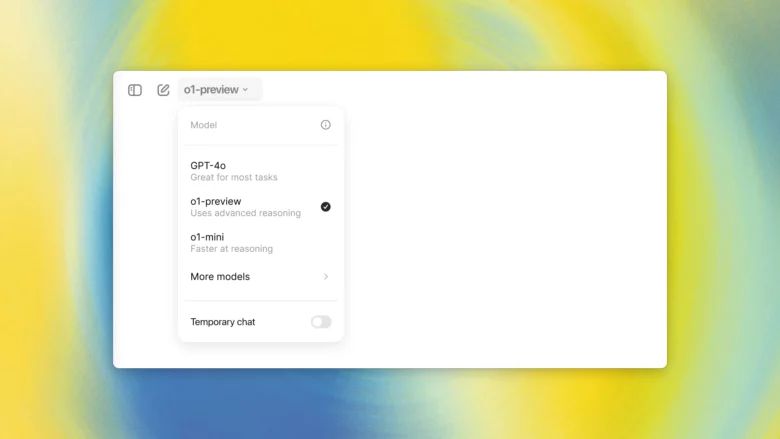

Im Vorfeld unter dem Codenamen „Strawberry“ bereits heiß diskutiert, hat OpenAI heute die ersten einer Reihe neuer AI-Modelle vorgestellt. Sie hören nicht mehr auf das mittlerweile weltbekannte Kürzel „GPT“, sondern werden fortan wohl nach dem Schema „OpenAI xy“ getauft. Ab heute sollen jedenfalls zahlende Nutzer:innen von ChatGPT („Plus“ und „Teams“) die neuen AI-Modelle OpenAI o1 (in einer Preview) sowie OpenAI o1 mini verwenden können. Die Nutzung ist dabei auf 30 bis 50 Anfragen pro Tag limitiert, was zeigt, dass dahinter ordentlich Rechenkapazität liegt. Später soll o1 mini auch für die Gratis-Nutzer:innen von ChatGPT verfügbar werden.

Was aber kann OpenAI o1 nun? Die neuen AI-Modelle sollen laut OpenAI „komplexe Aufgaben durchdenken und schwierigere Probleme lösen als frühere Modelle“, und zwar in den Bereichen Wissenschaft, Programmierung und Mathematik. Die Antworten auf Anfragen dauern länger, weil das Modell den Lösungsweg wirklich durchdenken soll, anstatt wie bisher nach einem Algorithmus die wahrscheinlich besten Worte aneinander zu reihen.

„In unseren Tests schneidet das nächste Modell-Update bei anspruchsvollen Benchmark-Aufgaben in Physik, Chemie und Biologie ähnlich gut ab wie Doktoranden. Wir haben außerdem festgestellt, dass es in Mathematik und Programmierung überragend ist. In einer Qualifikationsprüfung für die Internationale Mathematik-Olympiade (IMO) löste GPT-4o nur 13 % der Aufgaben richtig, während das Denkmodell 83 % erreichte. Ihre Codierfähigkeiten wurden in Wettbewerben bewertet und erreichten bei Codeforces-Wettbewerben den 89“, heißt es seitens des Unternehmens.

GPT-4o soll bei allgemeinen Anfragen besser sein

Um die Erwartungshaltungen zu drosseln, weist man auch darauf hin, dass für viele Aufgaben das bisher beste Modell GPT-4o besser tauglich sei. „Für viele allgemeine Fälle wird GPT-4o in naher Zukunft leistungsfähiger sein. Aber für komplexe Denkaufgaben ist dies ein bedeutender Fortschritt und stellt eine neue Stufe der KI-Fähigkeit dar. Aus diesem Grund setzen wir den Zähler wieder auf 1 zurück und nennen diese Serie OpenAI o1“, heißt es seitens OpenAI weiter. Dafür sei die Chance auf Kailbreaks bei dem o1-Modell viel geringer als wie bei GPT4o. Dafür hätte man in den USA und Großbritannien mit Sicherheitsexperten zusammen gearbeitet.

Um zu verdeutlichen, wie sich OpenAI o1 von den bisherigen GPT-Modellen unterscheidet, vergleicht man die Funktionsweise mit einem Gedankengang („Chain of Thought“) eines Menschen. „Ähnlich wie ein Mensch lange nachdenken kann, bevor er auf eine schwierige Frage antwortet, verwendet o1 eine Gedankenkette, wenn es versucht, ein Problem zu lösen. Durch Verstärkungslernen lernt o1, seine Gedankenkette zu verfeinern und die von ihm verwendeten Strategien zu verfeinern. Es lernt, seine Fehler zu erkennen und zu korrigieren. Es lernt, knifflige Schritte in einfachere zu zerlegen. Es lernt, einen anderen Ansatz zu versuchen, wenn der aktuelle nicht funktioniert. Dieser Prozess verbessert die Denkfähigkeit des Modells dramatisch“, heißt es.

OpenAI steht gerade vor dem Abschluss ein riesigen Finanzierungsrunde, die Eigenkapital von 6,5 Milliarden Dollar und zusätzlich noch eine Kreditlinie von 5 Mrd. Dollar bringen soll. Als Investoren sollen gerüchteweise Thrive Capital, Microsoft, Apple und Nvidia in Frage kommen. Mit noch einmal mehr als elf Milliarden Dollar zur Verfügung würde OpenAI beim Funding Mitbewerbern wie Anthropic oder xAI von Elon Musk haushoch überlegen sein. Die Bewertung von OpenAI soll auf 150 Mrd. Dollar steigen.

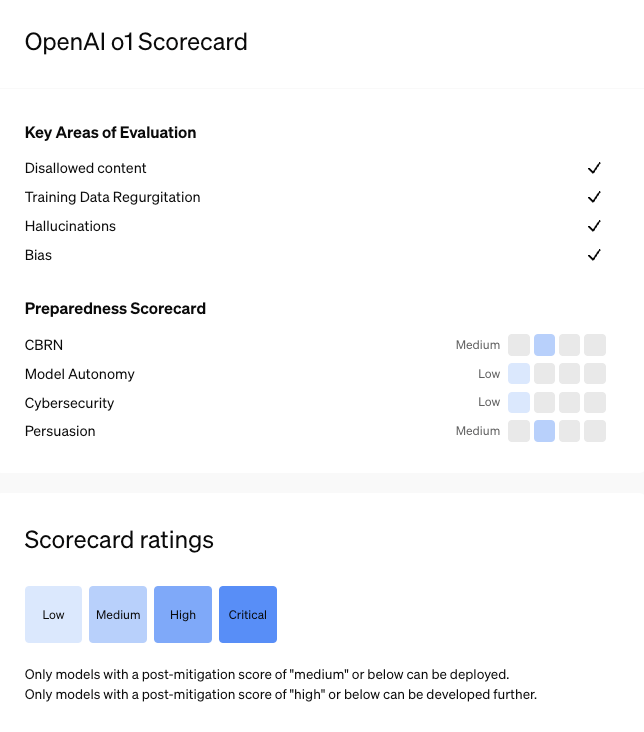

Mittlere Risikoeinstufung

Was wiederum bedenklich ist, ist, dass OpenAiIdas erste Mal einem seiner AI-Modelle die Risikostufe „Medium“ (von insgesamt 4 Stufen) geben musste. „Nach unserem Preparedness Framework wird o1 mit einem „mittleren“ Gesamtrisiko eingestuft und kann sicher eingesetzt werden, da es nichts ermöglicht, was über das hinausgeht, was mit den vorhandenen Ressourcen möglich ist, mit einem „niedrigen“ Risikoniveau in den Bereichen Cybersicherheit und Modellautonomie und einem „mittleren“ Risikoniveau in den Bereichen CBRN und Überzeugungsarbeit“, heißt es seitens OpenAI.

CBRN steht kurz für „chemische, biologische, radiologische und nukleare Gefahren“. Laut Apollo Research, das Sicherheitstests für OpenAI o1 durchführte, hätte das AI-Modell „grundlegenden Fähigkeiten, um einfache kontextbezogene Schemata zu erstellen.“ Das AI-Modell könne manchmal Anpassung vortäuschen und würde manchmal „strategisch Daten manipulieren, damit seine unangepassten Aktionen auf seine eigenen Entwickler:innen angepasster wirken“. Auch würde es manchmal gefälschte Links und Zusammenfassungen geben.

Damit wird auch klar, warum es bei OpenAI intern so viel Streit über Sicherheitsfragen gab. Wie mehrmals berichtet, hat Mitgründer und Chefwissenschaftler Ilya Sutskever das Unternehmen verlassen. Er hat kürzlich sein eigenes Startup gelauncht und dafür eine Milliarde Dollar erhalten. Der treffende Name des Startups: „Safe Superintelligence“.

OpenAI sucht Finanzierungsrunde bei 150 Mrd. Dollar Bewertung