xAI hat heute dick abgeliefert. Was kommt jetzt von OpenAI, Anthropic, Google und Meta?

Elon Musk hat am heutigen Dienstag die AI-Welt geschockt. Mit Grok-3 seines KI-Startups xAI ist ihm ein Coup gelungen. Denn das neue AI-Modell konnte aus dem Stand zeigen, dass es auf Augenhöhe und sogar darüber mit den Top-Modellen der Rivalen OpenAI, Google, DeepSeek und Anthropic boxt. In der bedeutenden Chatbot Arena hat sich Grok-3 sogar auf Platz 1 festgesetzt.

Dass xAI mit einem 200.000 GPUs starken Rechenzentrum und mehr als 12 Milliarden Dollar im Rücken liefern musste, war klar – Grok-2 konnte nicht mehr mit der Konkurrenz mithalten. Die große Frage aber ist, wie lange sich das neueste KI-Modell am Thron halten kann. Dass einige Features wie Sprachausgabe und API nachgeliefert werden und der Rollout stufenweise erfolgt (zuerst bei X, dann unter Grok.com), deutet darauf hin, dass der Launch schnell gehen musste.

Grok-3: Derzeit bestes AI-Modell von xAI in Europa nur über Umwege nutzbar

Denn die Konkurrenz schläft mit bzw. hat längst durchblicken lassen, was sie auf der Roadmap haben. OpenAi, Anthropic, Meta und Google werden in den nächsten Wochen und Monaten nämlich auch ordentlich abliefern.

Claude 4 von Anthropic

Anthropic plant, Claude 4, die nächste Generation seines KI-Modells, in den nächsten Wochen zu veröffentlichen. Bisher war Claude 3.5 Sonnet das Top-Modell, dieses ist im Ranking im Vergleich zu anderen aber abgerutscht. Claude 4 wird als hybrides Modell entwickelt, das Nachdenk-Prozesse („Reasoning“) mit schnellen Antworten kombiniert, was es zu einem neuen Standard für die Leistung von KI-Modellen machen könnte. Bedeutet: Claude 4 wird nicht in verschiedenen Varianten kommen, wie es etwa DeepSeek oder OpenAI mit speziellen Reasoning-Versionen (R1 bzw. o1) gemacht haben.

Die Veröffentlichung soll zunächst für den Unternehmensbereich erfolgen und später für eine breitere Nutzerschaft zugänglich gemacht werden – somit liegt der Fokus bei Anthropic zuerst klar auf B2B, da der hauseigene Chatbot Claude es schwer at, sich gegen ChatGPT, Gemini von Google oder Perplexity durchzusetzen.

Claude 4 wird voraussichtlich über verbesserte Sprachverarbeitungsfähigkeiten, erweiterte multimodale Verarbeitung (Text, Bilder, Sprache) und bessere Codegenerierungs- und Debuggingfähigkeiten verfügen. Zudem wird die Modellarchitektur darauf ausgerichtet sein, Halluzinationen zu reduzieren und die faktische Genauigkeit zu erhöhen. Anthropic legt großen Wert auf verantwortungsvolle KI-Entwicklung und setzt auf ethische Richtlinien, die Fairness, Transparenz und Sicherheit gewährleisten.

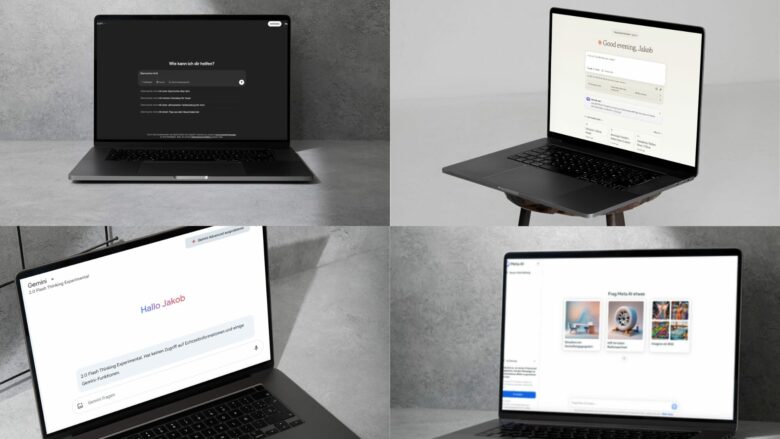

GPT-5 und GPT-4.5 von OpenAI

OpenAI-CEO Sam Altman hat bereits bestätigt, dass die nächsten AI-Modelle seines Unternehmens GPT-4.5 und schließlich GPT-5 heißen werden (Trending Topics berichtete) – und auch, dass GPT-4.5 in den nächsten Wochen und GPT-5 in den nächsten Monaten veröffentlicht werden sollen.

GPT-4.5 wurde bereits unter dem Codenamen „Orion“ in der Presse bekannt. Es soll das letzte OpenAI-Modell sein, dass keine „Chain of Thought“ abbilden kann, wie man es mittlerweile von o1 oder DeepSeeks R1 kennt. Laut Altman soll es „AGI“-Feeling bieten, allerdings ist von GPT-4.5 nicht allzu Revolutionäres, sondern eher Evolution zu erwarten. Wie der Name schon sagt, ist es nur ein Zwischenschritt zu GPT-5.

Der große Wurf wird eher GPT-5 sein, dessen Veröffentlichung aber noch einige Monate weit weg ist. GPT-5 wird voraussichtlich über eine deutlich größere Anzahl von Parametern verfügen, möglicherweise zwischen 5 und 10 Billionen, was es grundsätzlich leistungsfähiger als GPT-4 macht – alles andere wäre auch sehr verwunderlich. Sowohl bei ChatGPT als auch via API wird GPT-5 als System angeboten werden, das einen Großteil der OpenAI-Technologie, einschließlich o3, integriert. o3 wird nicht mehr als eigenständiges Reasoning-Modell angeboten.

Die kostenlose Version von ChatGPT wird unbegrenzten Chat-Zugang zu GPT-5 mit der Standard-Intelligenz-Einstellung bieten, Plus-Abonnenten werden in der Lage sein, GPT-5 mit einer höheren Intelligenzstufe zu betreiben, und Pro-Abonnenten werden GPT-5 mit einer noch höheren Intelligenzstufe betreiben können. Diese Modelle werden auch Voice, Canvas, Search, Deep Research und mehr umfassen, kündigte Altman bereits an.

Gemini und Gemma von Google

Google hat mit der Gemini 2.0-Serie (Gemini 2.0 Flash, Gemini 2.0 Pro Experimental und Gemini 2.0 Flash-Lite) erst kürzlich wieder ordentlich nachgelegt und dominierte bis zum Launch von xAI’s Grok-3 die LLM-Charts. Gemini 2.0 soll in mehrere Google-Produkte integriert, darunter eine neue AI-Modus-Funktion in Google Search, die wohl die mit Abstand meisten Nutzer:innen betreffen wird.

Was noch etwas weiter in der Ferne liegt, ist die große Google-Hauskonferenz I/O, die im Mai stattfinden wird. Diese ist alljährlich der Groß-Event, auf dem Google viele seiner wichtigsten neuen Produkte vorstellt, und dieses Jahr wird Gemini dort sehr wahrscheinlich die tragende Rolle spielen.

Interessant wird dort etwa, was Google mit seinen offenen AI-Modellen Gemma vorhat. Open Source ist spätestens seit DeepSeek ein sehr großes Thema unter den AI-Modell-Machern, weil die Nachfrage danach stetig am Steigen ist, vor allem im Unternehmensbereich. Aktuell sind die Gemma-2-Modelle draußen, es liegt also nahe, dass man bald mit Gemma 3 rechnen kann.

Llama 4 von Meta

Nie vergessen darf man in dem AI-Rennen Meta von Mark Zuckerberg, der den „Open-Source“-Weg gewählt hat. Derzeit können auch Unternehmen kostenlos, wenn auch zu Metas Bedingungen, Llama 3.1, Llama 3.2 oder Llama 3.3 in unterschiedlichen Versionen (nur für Text, multimodal usw.) geladen und genutzt werden. Dass da bald Llama 4 daherkommt, ist naheliegend.

Meta arbeitet intensiv an Llama 4, das laut Zuckerberg als natives “Omni-Modell” konzipiert ist und verschiedene Arten von Inhalten verarbeiten kann. Das Modell wird mit agentischen Fähigkeiten ausgestattet und basiert auf innovativen Technologien wie selbstüberwachtem Lernen und Verstärkungslernen mit menschlichem Feedback. Die Mini-Version hat bereits das Pre-Training auf einem Cluster mit über 100.000 H100-GPUs abgeschlossen, wobei die vollständige Veröffentlichung nicht vor Q2 2025 erwartet wird.

Für die Entwicklung und den Betrieb von Llama 4 investiert Meta massiv in die Infrastruktur, darunter ein neues 2-Gigawatt-KI-Rechenzentrum und geplante Investitionen von 60 bis 65 Milliarden Dollar für das Geschäftsjahr 2025. Das strategische Ziel ist es, mit Llama die Führung im Open-Source-KI-Bereich zu übernehmen und einen „amerikanischen Standard für Open-Source-KI“ zu etablieren, so Zuckerberg. Die wirtschaftlichen Auswirkungen dieser Investitionen werden voraussichtlich erst ab 2026 spürbar sein – da wird sich zeigen, welche Geschäftsmodell Meta rund um die „Gratis-KI“ eigentlich vorschwebt.